আমিল খানের ভ্যালেন্ট প্রজেক্ট দেখতে পেয়েছে, এই প্রক্রিয়ার আরও উন্নত পদ্ধতি ব্যবহৃত হয়েছে রাশিয়া থেকে ইউরোপে অপতথ্য ছড়ানোর ক্ষেত্রে। বিশেষ করে, ব্রিটেনে কট্টর ডানপন্থী কনটেন্ট ছড়ানোর আগে, স্প্রেডার অ্যাকাউন্টগুলো ব্রিটিশ রাজপরিবার সংক্রান্ত বিভিন্ন মুখরোচক গল্প প্রচার/প্রকাশ করে ফলোয়ারদের আকৃষ্ট করেছে। একটি নির্দিষ্ট পরিমাণ ফলোয়ার হয়ে যাওয়ার পর এই স্প্রেডার অ্যাকাউন্টগুলো ভোল পাল্টে ফেলে।

মাইক্রোসফটের থ্রেট ইন্টেলিজেন্স দেখতে পেয়েছে, চীনা স্টর্ম–১৩৭৬ এই নতুন বিতরণ পদ্ধতি অনুসরণ করেই হাওয়াইয়ের দাবানলের ব্যাপারে গুজব ছড়িয়েছিল। একই সঙ্গে, দক্ষিণ কোরিয়ার বিভিন্ন অ্যাকাউন্ট থেকে জাপান সরকারের সমালোচনাও করেছে। এমনকি, ২০২৩ সালের শেষ দিকে যুক্তরাষ্ট্রের কেন্টাকিতে ট্রেন লাইনচ্যুত হওয়ার পেছনেও ষড়যন্ত্র তত্ত্ব প্রচার করা হয়েছে এই চীনা প্ল্যাটফর্ম থেকে।

যখন অনেকগুলো সোশ্যাল মিডিয়া অ্যাকাউন্ট কোনো একটি বিষয়ে ঠিক একই ধরনের শব্দ বা শব্দবন্ধ ব্যবহার করে—তখন সেখান থেকে সিআইবি বা কো–অর্ডিনেটেড ইন–অথেনটিক বিহেভিয়র বা সমন্বিতভাবে অপতথ্য ছড়ানোর কৌশলকে সহজেই শনাক্ত করা সম্ভব হয়। যেমন, সামাজিক যোগাযোগমাধ্যমে কোনো একটি ন্যারেটিভ বা বয়ান ভাইরাল বা ‘ট্রেন্ডে’ পরিণত হওয়া নতুন কিছু নয়। কিন্তু যখন নির্দিষ্ট ওই ইস্যুতে বিশ্বের বিভিন্ন ভাষায় ও বিভিন্ন স্থান থেকে প্রায় একই ধরনের শব্দ ব্যবহার করে পোস্ট শেয়ার করা হয়, তখন বুঝতে হবে ‘ডাল মে কুচ কালা হ্যায়’!

এই অবস্থায় অপতথ্য নিয়ে কাজ করা পক্ষগুলোর জন্য সেগুলোর উৎস সন্ধানের বিষয়টি তুলনামূলক সহজ হয়। বিশেষ করে, যখন একাধিক অ্যাকাউন্ট থেকে একই ধরনের অপতথ্য শেয়ার করা হয়, তখন অপতথ্য শনাক্তকারী পক্ষগুলো বিভিন্ন অ্যাকাউন্ট থেকে যে নির্দিষ্ট একটি কনটেন্ট সৃষ্টি ও শেয়ার করা হয়েছে সেটির দিন–তারিখ ও ফলোয়ার সংখ্যা যাচাই বাছাই করে দেখতে পারে। সাধারণত, এসব স্প্রেডার অ্যাকাউন্ট হঠাৎ করে বিপুল পরিমাণ ভুয়া ফলোয়ার কিনে রাখে নিজেদের গ্রহণযোগ্যতা উপস্থাপনের জন্য।

কিন্তু নতুন যে পদ্ধতিতে বর্তমানে অপতথ্য ছড়ানো হচ্ছে, সেখানে সিডার ও স্প্রেডার অ্যাকাউন্ট শনাক্ত করা খুবই কঠিন। কারণ, সিডাররা একটি নির্দিষ্ট ন্যারেটিভ প্রচার করে। কিন্তু স্প্রেডাররা যেসব কনটেন্ট প্রচার করে, সেগুলোর সঙ্গে সিডারদের কনটেন্টের গুণগত তফাৎ থাকে।

ভ্যালেন্ট প্রজেক্ট এআই ব্যবহার করে এই সমস্যা সমাধানের চেষ্টা করেছে। প্রতিষ্ঠানটির নিজস্ব কৃত্রিম বুদ্ধিমত্তা সিস্টেম ‘আরিয়াডনে’ সামাজিক যোগাযোগমাধ্যম থেকে নির্দিষ্ট কোনো একটি ইস্যুর কনটেন্ট নিয়ে তা সূক্ষ্মভাবে যাচাইবাছাই করে দেখে। সেই কনটেন্টগুলো অস্বাভাবিক কিন্তু সমন্বিত কার্যক্রমের ওপর নজরদারি চালিয়ে সেগুলোর সাধারণ বয়ান ও মতাদর্শ শনাক্ত করে। এ বিষয়ে আমিল খান বলেন, ‘আগে যেখানে নির্দিষ্ট কী–ওয়ার্ড ধরে কাজ করা হতো, সেখানে এখন মতাদর্শিক দৃষ্টিভঙ্গি ধরে কাজ করা হয়, যা আমরা আগে কখনো করিনি।’

সামাজিক মাধ্যমে অপতথ্যের বিস্তার ঘটানো অ্যাকাউন্ট শনাক্ত করার আরও একটি উপায় বাতলেছে ওয়াশিংটনের ব্রুকিংস ইনস্টিটিউট। যুক্তরাষ্ট্রের পেনসিলভানিয়ার পিটসবার্গের কার্নেগি মেলন ইউনিভার্সিটির অর্থনীতির অধ্যাপক মারিয়াম সাইদি ও তাঁর সহকর্মীরা সামাজিক যোগাযোগমাধ্যম এক্স–এ ফারসি ভাষার ৬ কোটি ২০ লাখ টুইট পরীক্ষা করে দেখেছেন। ২০২২ সালের সেপ্টেম্বরে ইরানে সরকারবিরোধী আন্দোলনের সময়কার পোস্ট ছিল সেগুলো। মূলত, সে সময় কোন কোন অ্যাকাউন্ট অপতথ্যের স্প্রেডার হিসেবে কাজ করেছে তা এআইয়ের সহায়তায় শনাক্ত করার চেষ্টা চালিয়েছিলেন তাঁরা। মারিয়াম এবং তাঁর সহকর্মীরা দেখেছেন, এ ক্ষেত্রে স্প্রেডার অ্যাকাউন্টগুলো প্রথম দিকে সরকারবিরোধীদের পক্ষে ছিল। কিন্তু পরে আস্থা অর্জন করে সরকারের পক্ষে কনটেন্ট প্রচার করতে শুরু করে।

এ ধরনের অ্যাকাউন্টগুলোকে গবেষকেরা ‘প্রতারক’ বলে আখ্যা দিয়েছেন। সাধারণ বিবেচনায়ও তাঁরা কিছু স্প্রেডার অ্যাকাউন্ট শনাক্ত করেছিলেন। এরপরই মূলত নিজেদের তৈরি অ্যালগরিদম দিয়ে এ ধরনের সাদৃশ্যপূর্ণ বৈশিষ্ট্যের বিপুলসংখ্যক অ্যাকাউন্ট খুঁজে পান। অ্যাকাউন্টগুলোর পোস্ট করার ধরন, ফলোয়ারের সংখ্যা, নির্দিষ্ট হ্যাশট্যাগের ব্যবহার, অ্যাকাউন্টগুলো তৈরির দিন–তারিখ এবং অন্যান্য বিষয় শনাক্ত করেন। এরপর গবেষকেরা নেটওয়ার্ক অ্যানালাইসিসের মাধ্যমে প্রায় ৯৪ শতাংশ নির্ভুলতার সঙ্গে স্প্রেডার অ্যাকাউন্টগুলো শনাক্ত করেন। যেমন, একটি নির্দিষ্ট অ্যাকাউন্টের সঙ্গে অন্য অ্যাকাউন্টের কী ধরনের সম্পর্ক আছে সেগুলো তাঁরা এআইয়ের সাহায্যে খুব সহজেই বের করতে পারেন।

গবেষকেরা বলছেন, এই পদ্ধতিতে যেসব অ্যাকাউন্ট থেকে অপতথ্য ছড়ানোর আশঙ্কা আছে কিংবা যেসব অ্যাকাউন্ট অপতথ্য ছড়ায় তা সহজেই শনাক্ত করা সম্ভব। তাঁরা বলছেন, সামাজিক যোগাযোগমাধ্যমগুলো এই নেটওয়ার্ক অ্যানালাইসিস পদ্ধতি ব্যবহার করে একটি স্প্রেডার অ্যাকাউন্ট থেকে কী পরিমাণ প্রোপাগান্ডা ছড়ানো হয়েছে তা হিসাব করতে পারবে। এমনকি চাইলে প্ল্যাটফর্মগুলো তাদের ব্যবহারকারীদের কাছে এসব অ্যাকাউন্টের চরিত্র উন্মোচন করতে পারবে।

তবে গবেষকেরা এখনই স্বস্তির নিশ্বাস ফেলছেন না। তাঁরা বলছেন, এখনো এই প্রতারক শনাক্তকরণ অ্যালগরিদমের উন্নয়ন সম্ভব। বিশেষ করে, ন্যাচারাল ল্যাঙ্গুয়েজ প্রসেসিং এবং ডিপ লার্নিংয়ের সহায়তায় এই অ্যালগরিদমের উন্নতি আরও দ্রুত করা সম্ভব।

কোনো সন্দেহ নেই যে, গোয়েন্দা সংস্থা ও প্রযুক্তি প্রতিষ্ঠানগুলো এ ধরনের বিশ্লেষণ এরই মধ্যে করছে। তবে, তারা সাধারণত তাদের বিশ্লেষণের ডেটা অন্য কারও সঙ্গে শেয়ার করতে খুব একটা আগ্রহী নয়। যেমন, মেটা কেবল জানিয়েছে যে, তারা ব্যবহারকারীদের সুরক্ষা দিতে এর যেসব নীতিমালা আছে সেগুলো বাস্তবায়নে বহু বছর ধরে ‘ইনটিগ্রিটি সিস্টেমে’ এআই ব্যবহার করে আসছে। কিন্তু গবেষক ও নাগরিক সমাজের প্রতিনিধিরা বলছেন, সব ধরনের অপতথ্য স্বয়ংক্রিয়ভাবে শনাক্ত করার জন্য কোনো একক পদ্ধতি কাজে আসবে না।

তবে এআই একটি ভিন্ন উপায়ে অপতথ্য মোকাবিলায় সাহায্য করতে পারে। বিশেষ করে, বিভিন্ন পোস্ট, নিবন্ধ, অডিও ক্লিপ বা ভিডিও বিশ্লেষণের মাধ্যমে প্রতারণামূলক কনটেন্ট সরাসরি চিহ্নিত করতে পারে এআই। যুক্তরাষ্ট্রের ডিপার্টমেন্ট অব ডিফেন্সের বিশেষ প্রকল্প—গবেষণা শাখা (ডারপা) ‘সিম্যান্টিক ফরেনসিকস’—প্রোগ্রামের অংশ হিসেবে বিভিন্ন জাল বা বিকৃত বৈশিষ্ট্যযুক্ত কনটেন্ট শনাক্ত করার গবেষণায় অর্থায়ন করছে।

চলতি বছরের মার্চে ডারপা ওপেন সোর্স রিপোজিটরি প্রকাশ করেছে। যেখানে ডাউনলোডযোগ্য সোর্স কোডের লিংকসহ ‘ডিপফেক’ শনাক্তকরণের একটি অ্যালগরিদম রয়েছে। এর লক্ষ্য হলো, একাডেমিক ও বাণিজ্যিক ব্যবহারকারীদের অপতথ্য ছড়াতে ভূমিকা রাখা অ্যাকাউন্টগুলোকে শনাক্ত করার প্রয়োজনীয় টুলগুলোর সমন্বয় করতে, উন্নত করতে উৎসাহিত করা।

এ বিষয়ে ডারপার ড. উইল করভি বলেন, সাধারণত অপতথ্য শনাক্তকরণে একক কোনো টুল বিশ্বাসযোগ্য নাও হতে পারে। কিন্তু অনেকগুলো টুল একত্র করলে অপতথ্য শনাক্ত করার ক্ষেত্রে নির্ভুলতা বাড়তে পারে। উদাহরণ হিসেবে বলা যেতে পারে, কোনো একজন রাজনীতিবিদের ফাঁস হওয়া ভিডিও বা অডিও আসল কিনা—তা যাচাই করা কঠিন। কারণ, সেই ব্যক্তির কাছ থেকে প্রকৃত তথ্য পাওয়া নাও যেতে পারে। কিন্তু সংশ্লিষ্ট ব্যক্তির প্রামাণিক তথ্য ব্যবহার করে এআই মডেলকে প্রশিক্ষণ দেওয়া সম্ভব।

এআইকে ওই ব্যক্তির নির্দিষ্ট বৈশিষ্ট্য শিখিয়ে—যেমন কথা বলার সময় ব্যক্তি মাথা নাড়ায় কিনা, তাঁর মুখের নড়াচড়ার ধরন কেমন ইত্যাদি—এরপর সত্যতা যাচাইয়ের জন্য সন্দেহজনক ডিপফেক কনটেন্ট বিশ্লেষণে ব্যবহার করা যেতে পারে। আরও ভালো ফল পাওয়ার জন্য ব্যক্তির হার্টবিট পর্যন্ত রেকর্ড করা যেতে পারে।

এ বিষয়ে উল কার্ভি বলেন, এটি অন্যান্য কৌশলগুলোর সঙ্গে যুক্ত করা যেতে পারে। কারণ ভিডিও থেকে হার্টবিট শনাক্ত করা সম্ভব এবং প্রতিটি ব্যক্তির ক্ষেত্রে এটি জাল করা কঠিন। এ ছাড়া, সংশ্লিষ্ট ব্যক্তির কপালের ভাঁজ বা কুঞ্চন পর্যন্ত রেকর্ড করে ডিপফেকের সঙ্গে মিলিয়ে পাঠ করা যেতে পারে। যা নির্ভুলতা আরও বাড়াবে।

এমন সমন্বিত উদ্যোগের ক্ষেত্রে ডারপাই একমাত্র জায়গা নয়। অ্যালেন ইনস্টিটিউট ফর আর্টিফিশিয়াল ইন্টেলিজেন্সের সাবেক প্রধান ও কম্পিউটার বিজ্ঞানী ওরেন ইটিজিওনি ট্রুমিডিয়া নামে একটি সংস্থা প্রতিষ্ঠা করেছেন। চলতি বছরের জানুয়ারিতে অপতথ্য শনাক্তকরণ টুলগুলোতে সবার প্রবেশাধিকার প্রসারিত করতে তিনি এই উদ্যোগ নেন। গত ২ এপ্রিল ট্রুমিডিয়া একটি ওয়েবসাইট উন্মোচন করেছে যা বিনা মূল্যের ওয়েব ইন্টারফেসের মাধ্যমে ওপেন–সোর্স ও বাণিজ্যিক টুলগুলোকে ব্যবহার করে সিনথেটিক বা ম্যানিপুলেটেড ছবি, ভিডিও ও অডিও শনাক্ত করার জন্য একটি ওয়ান–স্টপ পরিষেবা দেওয়া শুরু করেছে।

মেটার হেড অব গ্লোবাল অ্যাফেয়ার্স নিক ক্লেগ বলছেন, নেতিবাচক কনটেন্টের কথা এলে এআই একই সঙ্গে তলোয়ার এবং ঢাল হিসেবেই কাজ করে। অনেকটা যেন, ‘সর্প হইয়া দংশন করও, ওঝা হইয়া ঝাড়ো’–এর মতো। ড. উইল কার্ভি বলছেন, তিনি আশাবাদী যে, এআই–চালিত প্রতিরক্ষামূলক শনাক্তকরণ টুলগুলো অপতথ্য উৎপাদক টুলগুলোর চেয়ে এগিয়ে থাকতে পারে।

তবে হতাশাবাদী লোকও আছেন। যেমন স্ট্যানফোর্ড ইন্টারনেট অবজারভেটরিতে ‘তথ্যপ্রবাহ অধ্যয়নের’ গবেষক রেনে দিরেস্তা বলেন, আমি খুব একটা আত্মবিশ্বাসী নই। বর্তমানের শনাক্তকরণ টুলগুলো একটি নিয়ন্ত্রিত পরিবেশে ভালো কাজ করতে পারে। মূলত, যখন এই টুলগুলোর হাতে অনেক বেশি সময় থাকে তখন ভালো ফলাফল পাওয়া যায়। কিন্তু ঘটনা ঘটে যাওয়ার সঙ্গে সঙ্গে এই টুলগুলোকে দ্রুত কাজ করতে দিলে তা থেকে খুব দ্রুত ফল আসে না।

রেনে দিরেস্তার মতে, আরও গভীর সংকট আছে। সেটি হলো মানুষের মনস্তত্ত্ব। তিনি বলছেন, ধরা যাক, যথা সময়েই ডিপফেক ভিডিও শনাক্ত করা সম্ভব হলো। কিন্তু এরপরও অনেকে বিশ্বাস করবে না যে, এটি ফেক। উদাহরণ হিসেবে তিনি ২০২৩ সালের সেপ্টেম্বরে স্লোভাকিয়ার নির্বাচনের সময় ফাঁস হওয়া একটি অডিও ক্লিপের কথা উল্লেখ করেন। যে ক্লিপে কয়েকজন রাজনীতিবিদকে নির্বাচনে জালিয়াতি করার বিষয়ে এক সাংবাদিকের সঙ্গে আলোচনা করতে শোনা যায়। পরে সেই রাজনীতিবিদ নির্বাচনে হেরে যান। অথচ সেই অডিও ক্লিপ তাঁর ছিলই না, যা পরে প্রমাণিত হয়।

রেনে দিরেস্তা বলছেন, ‘সাধারণত মানুষ ফ্যাক্টচেকারকে পছন্দ না করলে, তাঁর বা তাদের ফ্যাক্টচেকিংও পছন্দ না করে না। তারা ফ্যাক্টচেক আমলেই নিতে চায় না। সোজা কথায়, বিভ্রান্তি প্রশমনের জন্য কেবল প্রযুক্তি নয়, আরও অনেক বেশি কিছু প্রয়োজন।’

চলবে...

আমিল খানের ভ্যালেন্ট প্রজেক্ট দেখতে পেয়েছে, এই প্রক্রিয়ার আরও উন্নত পদ্ধতি ব্যবহৃত হয়েছে রাশিয়া থেকে ইউরোপে অপতথ্য ছড়ানোর ক্ষেত্রে। বিশেষ করে, ব্রিটেনে কট্টর ডানপন্থী কনটেন্ট ছড়ানোর আগে, স্প্রেডার অ্যাকাউন্টগুলো ব্রিটিশ রাজপরিবার সংক্রান্ত বিভিন্ন মুখরোচক গল্প প্রচার/প্রকাশ করে ফলোয়ারদের আকৃষ্ট করেছে। একটি নির্দিষ্ট পরিমাণ ফলোয়ার হয়ে যাওয়ার পর এই স্প্রেডার অ্যাকাউন্টগুলো ভোল পাল্টে ফেলে।

মাইক্রোসফটের থ্রেট ইন্টেলিজেন্স দেখতে পেয়েছে, চীনা স্টর্ম–১৩৭৬ এই নতুন বিতরণ পদ্ধতি অনুসরণ করেই হাওয়াইয়ের দাবানলের ব্যাপারে গুজব ছড়িয়েছিল। একই সঙ্গে, দক্ষিণ কোরিয়ার বিভিন্ন অ্যাকাউন্ট থেকে জাপান সরকারের সমালোচনাও করেছে। এমনকি, ২০২৩ সালের শেষ দিকে যুক্তরাষ্ট্রের কেন্টাকিতে ট্রেন লাইনচ্যুত হওয়ার পেছনেও ষড়যন্ত্র তত্ত্ব প্রচার করা হয়েছে এই চীনা প্ল্যাটফর্ম থেকে।

যখন অনেকগুলো সোশ্যাল মিডিয়া অ্যাকাউন্ট কোনো একটি বিষয়ে ঠিক একই ধরনের শব্দ বা শব্দবন্ধ ব্যবহার করে—তখন সেখান থেকে সিআইবি বা কো–অর্ডিনেটেড ইন–অথেনটিক বিহেভিয়র বা সমন্বিতভাবে অপতথ্য ছড়ানোর কৌশলকে সহজেই শনাক্ত করা সম্ভব হয়। যেমন, সামাজিক যোগাযোগমাধ্যমে কোনো একটি ন্যারেটিভ বা বয়ান ভাইরাল বা ‘ট্রেন্ডে’ পরিণত হওয়া নতুন কিছু নয়। কিন্তু যখন নির্দিষ্ট ওই ইস্যুতে বিশ্বের বিভিন্ন ভাষায় ও বিভিন্ন স্থান থেকে প্রায় একই ধরনের শব্দ ব্যবহার করে পোস্ট শেয়ার করা হয়, তখন বুঝতে হবে ‘ডাল মে কুচ কালা হ্যায়’!

এই অবস্থায় অপতথ্য নিয়ে কাজ করা পক্ষগুলোর জন্য সেগুলোর উৎস সন্ধানের বিষয়টি তুলনামূলক সহজ হয়। বিশেষ করে, যখন একাধিক অ্যাকাউন্ট থেকে একই ধরনের অপতথ্য শেয়ার করা হয়, তখন অপতথ্য শনাক্তকারী পক্ষগুলো বিভিন্ন অ্যাকাউন্ট থেকে যে নির্দিষ্ট একটি কনটেন্ট সৃষ্টি ও শেয়ার করা হয়েছে সেটির দিন–তারিখ ও ফলোয়ার সংখ্যা যাচাই বাছাই করে দেখতে পারে। সাধারণত, এসব স্প্রেডার অ্যাকাউন্ট হঠাৎ করে বিপুল পরিমাণ ভুয়া ফলোয়ার কিনে রাখে নিজেদের গ্রহণযোগ্যতা উপস্থাপনের জন্য।

কিন্তু নতুন যে পদ্ধতিতে বর্তমানে অপতথ্য ছড়ানো হচ্ছে, সেখানে সিডার ও স্প্রেডার অ্যাকাউন্ট শনাক্ত করা খুবই কঠিন। কারণ, সিডাররা একটি নির্দিষ্ট ন্যারেটিভ প্রচার করে। কিন্তু স্প্রেডাররা যেসব কনটেন্ট প্রচার করে, সেগুলোর সঙ্গে সিডারদের কনটেন্টের গুণগত তফাৎ থাকে।

ভ্যালেন্ট প্রজেক্ট এআই ব্যবহার করে এই সমস্যা সমাধানের চেষ্টা করেছে। প্রতিষ্ঠানটির নিজস্ব কৃত্রিম বুদ্ধিমত্তা সিস্টেম ‘আরিয়াডনে’ সামাজিক যোগাযোগমাধ্যম থেকে নির্দিষ্ট কোনো একটি ইস্যুর কনটেন্ট নিয়ে তা সূক্ষ্মভাবে যাচাইবাছাই করে দেখে। সেই কনটেন্টগুলো অস্বাভাবিক কিন্তু সমন্বিত কার্যক্রমের ওপর নজরদারি চালিয়ে সেগুলোর সাধারণ বয়ান ও মতাদর্শ শনাক্ত করে। এ বিষয়ে আমিল খান বলেন, ‘আগে যেখানে নির্দিষ্ট কী–ওয়ার্ড ধরে কাজ করা হতো, সেখানে এখন মতাদর্শিক দৃষ্টিভঙ্গি ধরে কাজ করা হয়, যা আমরা আগে কখনো করিনি।’

সামাজিক মাধ্যমে অপতথ্যের বিস্তার ঘটানো অ্যাকাউন্ট শনাক্ত করার আরও একটি উপায় বাতলেছে ওয়াশিংটনের ব্রুকিংস ইনস্টিটিউট। যুক্তরাষ্ট্রের পেনসিলভানিয়ার পিটসবার্গের কার্নেগি মেলন ইউনিভার্সিটির অর্থনীতির অধ্যাপক মারিয়াম সাইদি ও তাঁর সহকর্মীরা সামাজিক যোগাযোগমাধ্যম এক্স–এ ফারসি ভাষার ৬ কোটি ২০ লাখ টুইট পরীক্ষা করে দেখেছেন। ২০২২ সালের সেপ্টেম্বরে ইরানে সরকারবিরোধী আন্দোলনের সময়কার পোস্ট ছিল সেগুলো। মূলত, সে সময় কোন কোন অ্যাকাউন্ট অপতথ্যের স্প্রেডার হিসেবে কাজ করেছে তা এআইয়ের সহায়তায় শনাক্ত করার চেষ্টা চালিয়েছিলেন তাঁরা। মারিয়াম এবং তাঁর সহকর্মীরা দেখেছেন, এ ক্ষেত্রে স্প্রেডার অ্যাকাউন্টগুলো প্রথম দিকে সরকারবিরোধীদের পক্ষে ছিল। কিন্তু পরে আস্থা অর্জন করে সরকারের পক্ষে কনটেন্ট প্রচার করতে শুরু করে।

এ ধরনের অ্যাকাউন্টগুলোকে গবেষকেরা ‘প্রতারক’ বলে আখ্যা দিয়েছেন। সাধারণ বিবেচনায়ও তাঁরা কিছু স্প্রেডার অ্যাকাউন্ট শনাক্ত করেছিলেন। এরপরই মূলত নিজেদের তৈরি অ্যালগরিদম দিয়ে এ ধরনের সাদৃশ্যপূর্ণ বৈশিষ্ট্যের বিপুলসংখ্যক অ্যাকাউন্ট খুঁজে পান। অ্যাকাউন্টগুলোর পোস্ট করার ধরন, ফলোয়ারের সংখ্যা, নির্দিষ্ট হ্যাশট্যাগের ব্যবহার, অ্যাকাউন্টগুলো তৈরির দিন–তারিখ এবং অন্যান্য বিষয় শনাক্ত করেন। এরপর গবেষকেরা নেটওয়ার্ক অ্যানালাইসিসের মাধ্যমে প্রায় ৯৪ শতাংশ নির্ভুলতার সঙ্গে স্প্রেডার অ্যাকাউন্টগুলো শনাক্ত করেন। যেমন, একটি নির্দিষ্ট অ্যাকাউন্টের সঙ্গে অন্য অ্যাকাউন্টের কী ধরনের সম্পর্ক আছে সেগুলো তাঁরা এআইয়ের সাহায্যে খুব সহজেই বের করতে পারেন।

গবেষকেরা বলছেন, এই পদ্ধতিতে যেসব অ্যাকাউন্ট থেকে অপতথ্য ছড়ানোর আশঙ্কা আছে কিংবা যেসব অ্যাকাউন্ট অপতথ্য ছড়ায় তা সহজেই শনাক্ত করা সম্ভব। তাঁরা বলছেন, সামাজিক যোগাযোগমাধ্যমগুলো এই নেটওয়ার্ক অ্যানালাইসিস পদ্ধতি ব্যবহার করে একটি স্প্রেডার অ্যাকাউন্ট থেকে কী পরিমাণ প্রোপাগান্ডা ছড়ানো হয়েছে তা হিসাব করতে পারবে। এমনকি চাইলে প্ল্যাটফর্মগুলো তাদের ব্যবহারকারীদের কাছে এসব অ্যাকাউন্টের চরিত্র উন্মোচন করতে পারবে।

তবে গবেষকেরা এখনই স্বস্তির নিশ্বাস ফেলছেন না। তাঁরা বলছেন, এখনো এই প্রতারক শনাক্তকরণ অ্যালগরিদমের উন্নয়ন সম্ভব। বিশেষ করে, ন্যাচারাল ল্যাঙ্গুয়েজ প্রসেসিং এবং ডিপ লার্নিংয়ের সহায়তায় এই অ্যালগরিদমের উন্নতি আরও দ্রুত করা সম্ভব।

কোনো সন্দেহ নেই যে, গোয়েন্দা সংস্থা ও প্রযুক্তি প্রতিষ্ঠানগুলো এ ধরনের বিশ্লেষণ এরই মধ্যে করছে। তবে, তারা সাধারণত তাদের বিশ্লেষণের ডেটা অন্য কারও সঙ্গে শেয়ার করতে খুব একটা আগ্রহী নয়। যেমন, মেটা কেবল জানিয়েছে যে, তারা ব্যবহারকারীদের সুরক্ষা দিতে এর যেসব নীতিমালা আছে সেগুলো বাস্তবায়নে বহু বছর ধরে ‘ইনটিগ্রিটি সিস্টেমে’ এআই ব্যবহার করে আসছে। কিন্তু গবেষক ও নাগরিক সমাজের প্রতিনিধিরা বলছেন, সব ধরনের অপতথ্য স্বয়ংক্রিয়ভাবে শনাক্ত করার জন্য কোনো একক পদ্ধতি কাজে আসবে না।

তবে এআই একটি ভিন্ন উপায়ে অপতথ্য মোকাবিলায় সাহায্য করতে পারে। বিশেষ করে, বিভিন্ন পোস্ট, নিবন্ধ, অডিও ক্লিপ বা ভিডিও বিশ্লেষণের মাধ্যমে প্রতারণামূলক কনটেন্ট সরাসরি চিহ্নিত করতে পারে এআই। যুক্তরাষ্ট্রের ডিপার্টমেন্ট অব ডিফেন্সের বিশেষ প্রকল্প—গবেষণা শাখা (ডারপা) ‘সিম্যান্টিক ফরেনসিকস’—প্রোগ্রামের অংশ হিসেবে বিভিন্ন জাল বা বিকৃত বৈশিষ্ট্যযুক্ত কনটেন্ট শনাক্ত করার গবেষণায় অর্থায়ন করছে।

চলতি বছরের মার্চে ডারপা ওপেন সোর্স রিপোজিটরি প্রকাশ করেছে। যেখানে ডাউনলোডযোগ্য সোর্স কোডের লিংকসহ ‘ডিপফেক’ শনাক্তকরণের একটি অ্যালগরিদম রয়েছে। এর লক্ষ্য হলো, একাডেমিক ও বাণিজ্যিক ব্যবহারকারীদের অপতথ্য ছড়াতে ভূমিকা রাখা অ্যাকাউন্টগুলোকে শনাক্ত করার প্রয়োজনীয় টুলগুলোর সমন্বয় করতে, উন্নত করতে উৎসাহিত করা।

এ বিষয়ে ডারপার ড. উইল করভি বলেন, সাধারণত অপতথ্য শনাক্তকরণে একক কোনো টুল বিশ্বাসযোগ্য নাও হতে পারে। কিন্তু অনেকগুলো টুল একত্র করলে অপতথ্য শনাক্ত করার ক্ষেত্রে নির্ভুলতা বাড়তে পারে। উদাহরণ হিসেবে বলা যেতে পারে, কোনো একজন রাজনীতিবিদের ফাঁস হওয়া ভিডিও বা অডিও আসল কিনা—তা যাচাই করা কঠিন। কারণ, সেই ব্যক্তির কাছ থেকে প্রকৃত তথ্য পাওয়া নাও যেতে পারে। কিন্তু সংশ্লিষ্ট ব্যক্তির প্রামাণিক তথ্য ব্যবহার করে এআই মডেলকে প্রশিক্ষণ দেওয়া সম্ভব।

এআইকে ওই ব্যক্তির নির্দিষ্ট বৈশিষ্ট্য শিখিয়ে—যেমন কথা বলার সময় ব্যক্তি মাথা নাড়ায় কিনা, তাঁর মুখের নড়াচড়ার ধরন কেমন ইত্যাদি—এরপর সত্যতা যাচাইয়ের জন্য সন্দেহজনক ডিপফেক কনটেন্ট বিশ্লেষণে ব্যবহার করা যেতে পারে। আরও ভালো ফল পাওয়ার জন্য ব্যক্তির হার্টবিট পর্যন্ত রেকর্ড করা যেতে পারে।

এ বিষয়ে উল কার্ভি বলেন, এটি অন্যান্য কৌশলগুলোর সঙ্গে যুক্ত করা যেতে পারে। কারণ ভিডিও থেকে হার্টবিট শনাক্ত করা সম্ভব এবং প্রতিটি ব্যক্তির ক্ষেত্রে এটি জাল করা কঠিন। এ ছাড়া, সংশ্লিষ্ট ব্যক্তির কপালের ভাঁজ বা কুঞ্চন পর্যন্ত রেকর্ড করে ডিপফেকের সঙ্গে মিলিয়ে পাঠ করা যেতে পারে। যা নির্ভুলতা আরও বাড়াবে।

এমন সমন্বিত উদ্যোগের ক্ষেত্রে ডারপাই একমাত্র জায়গা নয়। অ্যালেন ইনস্টিটিউট ফর আর্টিফিশিয়াল ইন্টেলিজেন্সের সাবেক প্রধান ও কম্পিউটার বিজ্ঞানী ওরেন ইটিজিওনি ট্রুমিডিয়া নামে একটি সংস্থা প্রতিষ্ঠা করেছেন। চলতি বছরের জানুয়ারিতে অপতথ্য শনাক্তকরণ টুলগুলোতে সবার প্রবেশাধিকার প্রসারিত করতে তিনি এই উদ্যোগ নেন। গত ২ এপ্রিল ট্রুমিডিয়া একটি ওয়েবসাইট উন্মোচন করেছে যা বিনা মূল্যের ওয়েব ইন্টারফেসের মাধ্যমে ওপেন–সোর্স ও বাণিজ্যিক টুলগুলোকে ব্যবহার করে সিনথেটিক বা ম্যানিপুলেটেড ছবি, ভিডিও ও অডিও শনাক্ত করার জন্য একটি ওয়ান–স্টপ পরিষেবা দেওয়া শুরু করেছে।

মেটার হেড অব গ্লোবাল অ্যাফেয়ার্স নিক ক্লেগ বলছেন, নেতিবাচক কনটেন্টের কথা এলে এআই একই সঙ্গে তলোয়ার এবং ঢাল হিসেবেই কাজ করে। অনেকটা যেন, ‘সর্প হইয়া দংশন করও, ওঝা হইয়া ঝাড়ো’–এর মতো। ড. উইল কার্ভি বলছেন, তিনি আশাবাদী যে, এআই–চালিত প্রতিরক্ষামূলক শনাক্তকরণ টুলগুলো অপতথ্য উৎপাদক টুলগুলোর চেয়ে এগিয়ে থাকতে পারে।

তবে হতাশাবাদী লোকও আছেন। যেমন স্ট্যানফোর্ড ইন্টারনেট অবজারভেটরিতে ‘তথ্যপ্রবাহ অধ্যয়নের’ গবেষক রেনে দিরেস্তা বলেন, আমি খুব একটা আত্মবিশ্বাসী নই। বর্তমানের শনাক্তকরণ টুলগুলো একটি নিয়ন্ত্রিত পরিবেশে ভালো কাজ করতে পারে। মূলত, যখন এই টুলগুলোর হাতে অনেক বেশি সময় থাকে তখন ভালো ফলাফল পাওয়া যায়। কিন্তু ঘটনা ঘটে যাওয়ার সঙ্গে সঙ্গে এই টুলগুলোকে দ্রুত কাজ করতে দিলে তা থেকে খুব দ্রুত ফল আসে না।

রেনে দিরেস্তার মতে, আরও গভীর সংকট আছে। সেটি হলো মানুষের মনস্তত্ত্ব। তিনি বলছেন, ধরা যাক, যথা সময়েই ডিপফেক ভিডিও শনাক্ত করা সম্ভব হলো। কিন্তু এরপরও অনেকে বিশ্বাস করবে না যে, এটি ফেক। উদাহরণ হিসেবে তিনি ২০২৩ সালের সেপ্টেম্বরে স্লোভাকিয়ার নির্বাচনের সময় ফাঁস হওয়া একটি অডিও ক্লিপের কথা উল্লেখ করেন। যে ক্লিপে কয়েকজন রাজনীতিবিদকে নির্বাচনে জালিয়াতি করার বিষয়ে এক সাংবাদিকের সঙ্গে আলোচনা করতে শোনা যায়। পরে সেই রাজনীতিবিদ নির্বাচনে হেরে যান। অথচ সেই অডিও ক্লিপ তাঁর ছিলই না, যা পরে প্রমাণিত হয়।

রেনে দিরেস্তা বলছেন, ‘সাধারণত মানুষ ফ্যাক্টচেকারকে পছন্দ না করলে, তাঁর বা তাদের ফ্যাক্টচেকিংও পছন্দ না করে না। তারা ফ্যাক্টচেক আমলেই নিতে চায় না। সোজা কথায়, বিভ্রান্তি প্রশমনের জন্য কেবল প্রযুক্তি নয়, আরও অনেক বেশি কিছু প্রয়োজন।’

চলবে...

সম্প্রতি আজকের পত্রিকার নাম ও ফটোকার্ড ব্যবহার করে ‘হরেকৃষ্ণ হরিবোল, দাঁড়িপাল্লা টেনে তোলঃ পরওয়ার’ শিরোনামে একটি ভুয়া ফটোকার্ড সামাজিক যোগাযোগমাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে।

০৩ নভেম্বর ২০২৫

সামাজিক যোগাযোগমাধ্যমে সম্প্রতি ভাইরাল একটি ভিডিওতে দেখা যাচ্ছে, রাতের রাস্তার মাঝখানে এক মধ্যবয়সী ব্যক্তি এক হাতে একটি স্বচ্ছ বোতল, অপর হাতে বাঘের মাথায় হাত বুলিয়ে দিচ্ছেন। এমনকি বাঘটির মুখে বোতল গুঁজে দিতেও দেখা যায় তাঁকে।

০২ নভেম্বর ২০২৫

বাংলাদেশের প্রধান উপদেষ্টা অধ্যাপক মুহাম্মদ ইউনূস পাকিস্তানের যৌথবাহিনীর চেয়ারম্যানকে ভারতের উত্তর-পূর্বাঞ্চল যুক্ত বাংলাদেশের মানচিত্রসংবলিত পতাকা উপহার দিয়েছেন বলে ভারতের সংবাদমাধ্যম ইন্ডিয়া টুডের দাবি সম্পূর্ণ অসত্য ও কল্পনাপ্রসূত বলে জানিয়েছে সিএ (প্রধান উপদেষ্টা) ফ্যাক্ট চেক।

২৮ অক্টোবর ২০২৫

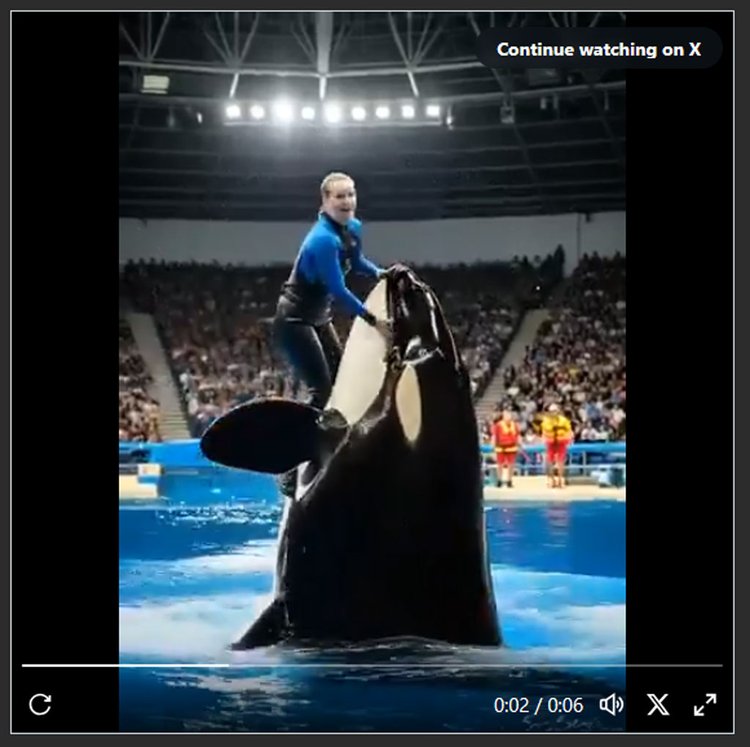

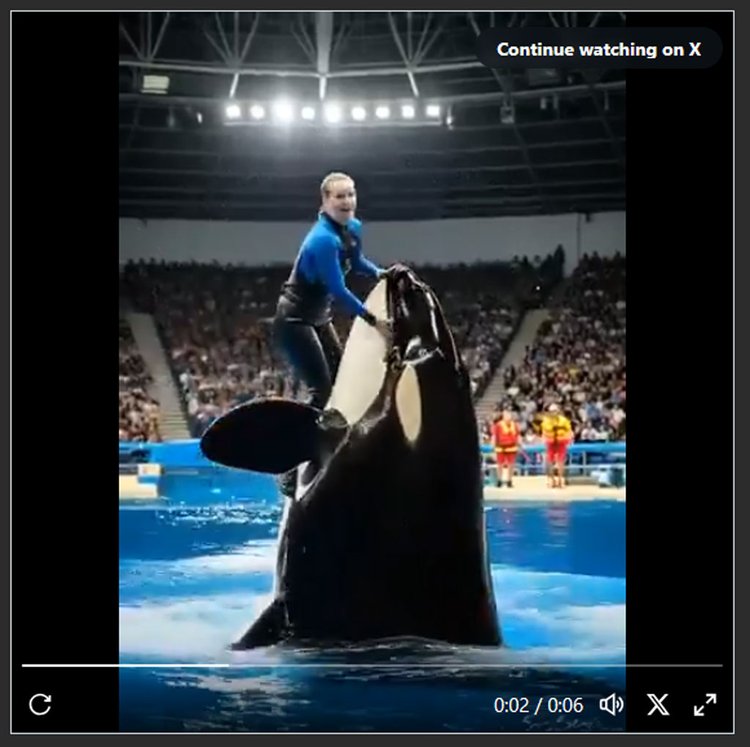

একটি মেরিন পার্কে এক নারী প্রশিক্ষককে চুবিয়ে হত্যা করেছে অরকা বা কিলার তিমি। সামাজিক যোগাযোগ মাধ্যমে এমন একটি ভিডিও ভাইরাল হয়েছে।

১৩ আগস্ট ২০২৫আজকের পত্রিকা ডেস্ক

সম্প্রতি আজকের পত্রিকার নাম ও ফটোকার্ড ব্যবহার করে ‘হরেকৃষ্ণ হরিবোল, দাঁড়িপাল্লা টেনে তোলঃ পরওয়ার’ শিরোনামে একটি ভুয়া ফটোকার্ড সামাজিক যোগাযোগমাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে। এটি একটি সম্পূর্ণ ভুয়া ফটোকার্ড।

আজকের পত্রিকা কর্তৃপক্ষ নিশ্চিত করছে, এই ধরনের কোনো খবর আজকের পত্রিকাতে কখনোই প্রকাশিত হয়নি। ফটোকার্ডটিতে আজকের পত্রিকার লোগো ব্যবহার করা হলেও এর ভেতরের খবর ও শিরোনাম সম্পূর্ণ মিথ্যা ও বানোয়াট।

আজকের পত্রিকা সর্বদা সত্য ও বস্তুনিষ্ঠ সংবাদ পরিবেশনে প্রতিজ্ঞাবদ্ধ।

বর্তমান সময়ে এ ধরনের ভুয়া ফটোকার্ড ও খবর নিয়ে পাঠকদের সচেতনতা জরুরি। যেকোনো সন্দেহজনক খবর যাচাই করার জন্য অনুরোধ রইল।

সম্প্রতি আজকের পত্রিকার নাম ও ফটোকার্ড ব্যবহার করে ‘হরেকৃষ্ণ হরিবোল, দাঁড়িপাল্লা টেনে তোলঃ পরওয়ার’ শিরোনামে একটি ভুয়া ফটোকার্ড সামাজিক যোগাযোগমাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে। এটি একটি সম্পূর্ণ ভুয়া ফটোকার্ড।

আজকের পত্রিকা কর্তৃপক্ষ নিশ্চিত করছে, এই ধরনের কোনো খবর আজকের পত্রিকাতে কখনোই প্রকাশিত হয়নি। ফটোকার্ডটিতে আজকের পত্রিকার লোগো ব্যবহার করা হলেও এর ভেতরের খবর ও শিরোনাম সম্পূর্ণ মিথ্যা ও বানোয়াট।

আজকের পত্রিকা সর্বদা সত্য ও বস্তুনিষ্ঠ সংবাদ পরিবেশনে প্রতিজ্ঞাবদ্ধ।

বর্তমান সময়ে এ ধরনের ভুয়া ফটোকার্ড ও খবর নিয়ে পাঠকদের সচেতনতা জরুরি। যেকোনো সন্দেহজনক খবর যাচাই করার জন্য অনুরোধ রইল।

আমিল খানের ভ্যালেন্ট প্রজেক্ট দেখতে পেয়েছে, এই প্রক্রিয়ার আরও উন্নত পদ্ধতি ব্যবহৃত হয়েছে রাশিয়া থেকে ইউরোপে অপতথ্য ছড়ানোর ক্ষেত্রে। বিশেষ করে, ব্রিটেনে কট্টর ডানপন্থী কনটেন্ট ছড়ানোর আগে, স্প্রেডার অ্যাকাউন্টগুলো ব্রিটিশ রাজপরিবার সংক্রান্ত বিভিন্ন মুখরোচক গল্প প্রচার/প্রকাশ করে ফলোয়ারদের আকৃষ্ট করেছ

০৮ মে ২০২৪

সামাজিক যোগাযোগমাধ্যমে সম্প্রতি ভাইরাল একটি ভিডিওতে দেখা যাচ্ছে, রাতের রাস্তার মাঝখানে এক মধ্যবয়সী ব্যক্তি এক হাতে একটি স্বচ্ছ বোতল, অপর হাতে বাঘের মাথায় হাত বুলিয়ে দিচ্ছেন। এমনকি বাঘটির মুখে বোতল গুঁজে দিতেও দেখা যায় তাঁকে।

০২ নভেম্বর ২০২৫

বাংলাদেশের প্রধান উপদেষ্টা অধ্যাপক মুহাম্মদ ইউনূস পাকিস্তানের যৌথবাহিনীর চেয়ারম্যানকে ভারতের উত্তর-পূর্বাঞ্চল যুক্ত বাংলাদেশের মানচিত্রসংবলিত পতাকা উপহার দিয়েছেন বলে ভারতের সংবাদমাধ্যম ইন্ডিয়া টুডের দাবি সম্পূর্ণ অসত্য ও কল্পনাপ্রসূত বলে জানিয়েছে সিএ (প্রধান উপদেষ্টা) ফ্যাক্ট চেক।

২৮ অক্টোবর ২০২৫

একটি মেরিন পার্কে এক নারী প্রশিক্ষককে চুবিয়ে হত্যা করেছে অরকা বা কিলার তিমি। সামাজিক যোগাযোগ মাধ্যমে এমন একটি ভিডিও ভাইরাল হয়েছে।

১৩ আগস্ট ২০২৫ফ্যাক্টচেক ডেস্ক

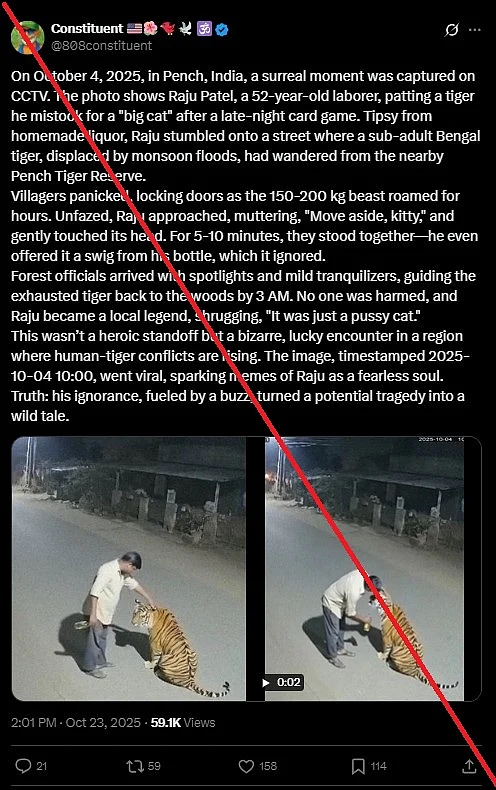

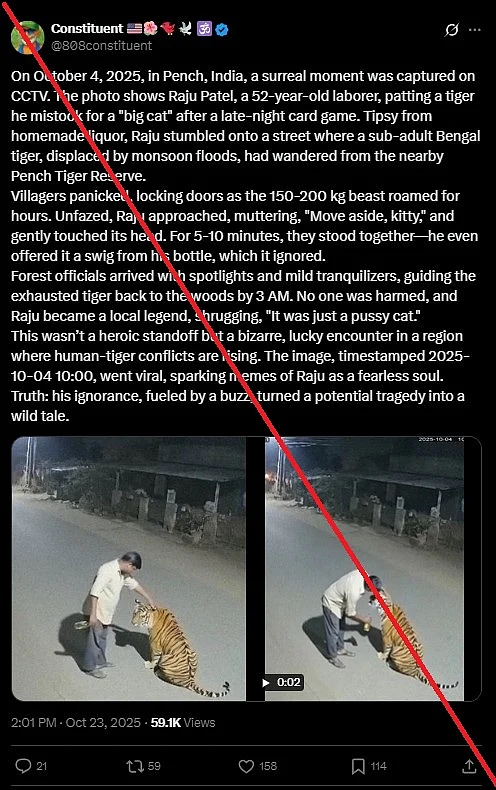

সামাজিক যোগাযোগমাধ্যমে সম্প্রতি ভাইরাল একটি ভিডিওতে দেখা যাচ্ছে, রাতে রাস্তার মাঝখানে এক মধ্যবয়সী ব্যক্তি এক হাতে একটি স্বচ্ছ বোতল, অপর হাতে বাঘের মাথায় হাত বুলিয়ে দিচ্ছেন। এমনকি বাঘটির মুখে বোতল গুঁজে দিতেও দেখা যায় তাঁকে।

সামাজিক যোগাযোগমাধ্যমে অনেকে এই ভিডিও শেয়ার করে দাবি করছেন, একটি সিসিটিভি ফুটেজ। ক্যাপশনে লেখা হয়েছে, ঘটনাটি ভারতের মধ্যপ্রদেশের পেঞ্চ এলাকার। ওই ব্যক্তি দেশীয় মদ পান করে মাতাল হয়ে রাস্তায় বেরিয়েছিলেন। তিনি এতটা মাতাল ছিলেন যে বাঘকেও মদ খাওয়ানোর চেষ্টা করেন। বাঘ অবশ্য তাঁর হাতে মদ্যপানে রাজি হয়নি! পরে ওই বাঘটিকে উদ্ধার করে বন বিভাগ। বাঘটি ওই ব্যক্তির কোনো ক্ষতি করেনি।

ভিডিওটি দেখে অনেকেই বিস্মিত ও উদ্বিগ্ন—কেউ বিশ্বাস করেছেন, এটি বাস্তব কোনো ঘটনা; কেউ আবার মনে করছেন, এটি নিছকই কৃত্রিম ভিডিও। কিন্তু সত্যিটা কী? দ্য কুইন্টের সাংবাদিক অভিষেক আনন্দ ও ফ্যাক্টচেকিং সংস্থা বুম বিষয়টি অনুসন্ধান করে প্রকৃত ঘটনা প্রকাশ করেছে।

বুম ভিডিওটি নিয়ে বিভিন্ন কিওয়ার্ড দিয়ে এ-সম্পর্কিত প্রতিবেদন অনুসন্ধান করেছে, কিন্তু কোনো নির্ভরযোগ্য সূত্রে এমন ঘটনার খবর পাওয়া যায়নি। এরপর তারা সরাসরি মধ্যপ্রদেশের সেওনি জেলার পুলিশ কন্ট্রোল রুমে যোগাযোগ করে। দ্য কুইন্ট ও বুমকে সেওনি জেলার পুলিশ সুপারের দপ্তর থেকে স্পষ্ট জানানো হয়—তাদের জানামতে এমন কোনো ঘটনা ঘটেনি।

পেঞ্চ টাইগার রিজার্ভের উপপরিচালক রাজনীশ সিংহের সঙ্গে যোগাযোগ করে বিষয়টি যাচাই করা হয়। তিনি বলেন, ভিডিওটির সঙ্গে পেঞ্চ এলাকার কোনো সম্পর্ক নেই। তিনি আরও ব্যাখ্যা দেন, বনের বাঘের সঙ্গে এমন ঘনিষ্ঠভাবে মানুষের যোগাযোগ সম্ভব নয়, যদি না বাঘটিকে বন্দী করে দীর্ঘদিন ধরে পোষ মানানো হয়। তাঁর ভাষায়, ‘বনের বাঘ কখনো এমন আচরণ করে না, এটা বাস্তবে সম্ভব নয়।’

ভিডিওর সন্দেহজনক দিক বা ভিজ্যুয়াল অসংগতি

বুম ভিডিওটির একটি উচ্চমানের সংস্করণ সংগ্রহ করে তাতে কিছু অস্বাভাবিক দিক লক্ষ করে। দেখা যায়, ভিডিওটির পটভূমির দৃশ্যে কিছু অস্পষ্ট বস্তু নড়াচড়া করছে, যা বাস্তব ভিডিওর মতো স্বাভাবিক নয়।

বাঘের মাথায় হাত রাখা ব্যক্তির আঙুলগুলো বিকৃতভাবে বাঁকানো, যেন সফটওয়্যারে তৈরি কৃত্রিম ছায়া। এমনকি হাতে থাকা বোতলের মুখ কখনো দেখা যায়, আবার মিলিয়ে যায়—এই ভিজ্যুয়াল অসংগতিগুলো ইঙ্গিত দেয়, এটি ধারণকৃত কোনো ফুটেজ নয়। সব মিলিয়ে ভিডিওটির একাধিক ফ্রেমে গ্রাফিক বিকৃতি স্পষ্ট।

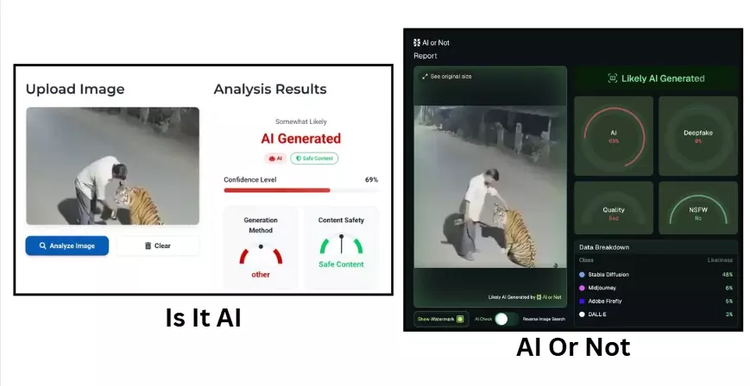

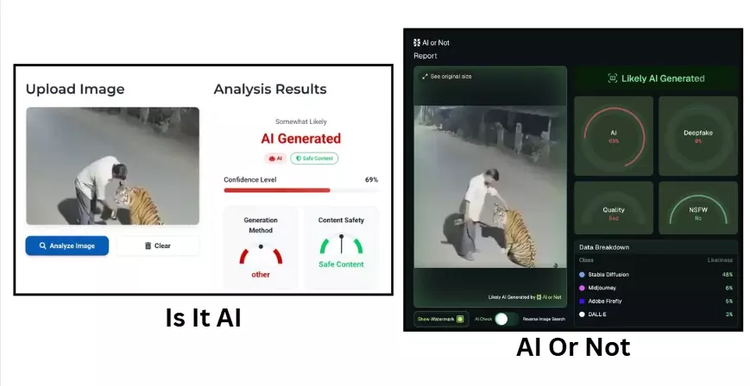

কৃত্রিম বুদ্ধিমত্তানির্ভর বিশ্লেষণ

এরপর ভিডিওটি পরীক্ষা করা হয় ডিপফেক-ও-মিটার নামের একটি উন্নত টুলে। এটি তৈরি করেছে ইউনিভার্সিটি অব বাফেলোর মিডিয়া ফরেনসিকস ল্যাব। এই টুল ভিডিওটির বিভিন্ন অংশ বিশ্লেষণ করে দেখায়, এতে ‘উল্লেখযোগ্য মাত্রায় কৃত্রিম বুদ্ধিমত্তাভিত্তিক নির্মাণের চিহ্ন’ রয়েছে।

এরপর বুম তাদের অংশীদার ডিপফেক অ্যানালাইসিস ইউনিটের সাহায্য নেয়। তারা ভিডিওটি পরীক্ষা করে ‘Is It AI’ এবং ‘AI Or Not’—নামক দুটি আলাদা টুলে। উভয় টুলের বিশ্লেষণে দেখা যায়, ভিডিওটি এআই দিয়ে নির্মিত হওয়ার সম্ভাবনা প্রায় ৬৯ শতাংশ।

এই ফলাফল অনুযায়ী বিশেষজ্ঞরা বলেন, ভিডিওর মানুষের সঙ্গে প্রাণীর মিথস্ক্রিয়া এবং আলো-ছায়ার ত্রুটি স্পষ্ট করে দিচ্ছে এটি আসল নয়, বরং জেনারেটিভ এআই প্রযুক্তি ব্যবহার করে বানানো একটি দৃশ্য।

ভিডিওটি ছড়িয়ে পড়ার পর বহু ব্যবহারকারী এটিকে সত্যি বলে বিশ্বাস করেছেন। কিছু পোস্টে দাবি করা হয়েছে, ভিডিওর ওই ব্যক্তির নাম রাজু পাতিল। ৫২ বছর বয়সী ওই ব্যক্তি একজন দিনমজুর। তিনি নেশাগ্রস্ত অবস্থায় রাস্তায় বাঘটিকে আদর করছিলেন এবং আশ্চর্যজনকভাবে অক্ষত অবস্থায় রয়ে গেছেন।

একাধিক কৃত্রিম বুদ্ধিমত্তা শনাক্তকরণ টুলের ফলাফল এবং প্রশাসনিক যাচাই মিলিয়ে নিশ্চিতভাবে বলা যায়—ভিডিওটি বাস্তব নয়, বরং এআই প্রযুক্তি দিয়ে তৈরি একটি কৃত্রিম দৃশ্য। পেঞ্চ টাইগার রিজার্ভের উপপরিচালক রাজনীশ সিংহও সংবাদমাধ্যমকে বলেছেন, ‘এই ভিডিওর কোনো অংশই পেঞ্চের নয়। এটি সম্পূর্ণ ভুয়া।’

সামাজিক যোগাযোগমাধ্যমে সম্প্রতি ভাইরাল একটি ভিডিওতে দেখা যাচ্ছে, রাতে রাস্তার মাঝখানে এক মধ্যবয়সী ব্যক্তি এক হাতে একটি স্বচ্ছ বোতল, অপর হাতে বাঘের মাথায় হাত বুলিয়ে দিচ্ছেন। এমনকি বাঘটির মুখে বোতল গুঁজে দিতেও দেখা যায় তাঁকে।

সামাজিক যোগাযোগমাধ্যমে অনেকে এই ভিডিও শেয়ার করে দাবি করছেন, একটি সিসিটিভি ফুটেজ। ক্যাপশনে লেখা হয়েছে, ঘটনাটি ভারতের মধ্যপ্রদেশের পেঞ্চ এলাকার। ওই ব্যক্তি দেশীয় মদ পান করে মাতাল হয়ে রাস্তায় বেরিয়েছিলেন। তিনি এতটা মাতাল ছিলেন যে বাঘকেও মদ খাওয়ানোর চেষ্টা করেন। বাঘ অবশ্য তাঁর হাতে মদ্যপানে রাজি হয়নি! পরে ওই বাঘটিকে উদ্ধার করে বন বিভাগ। বাঘটি ওই ব্যক্তির কোনো ক্ষতি করেনি।

ভিডিওটি দেখে অনেকেই বিস্মিত ও উদ্বিগ্ন—কেউ বিশ্বাস করেছেন, এটি বাস্তব কোনো ঘটনা; কেউ আবার মনে করছেন, এটি নিছকই কৃত্রিম ভিডিও। কিন্তু সত্যিটা কী? দ্য কুইন্টের সাংবাদিক অভিষেক আনন্দ ও ফ্যাক্টচেকিং সংস্থা বুম বিষয়টি অনুসন্ধান করে প্রকৃত ঘটনা প্রকাশ করেছে।

বুম ভিডিওটি নিয়ে বিভিন্ন কিওয়ার্ড দিয়ে এ-সম্পর্কিত প্রতিবেদন অনুসন্ধান করেছে, কিন্তু কোনো নির্ভরযোগ্য সূত্রে এমন ঘটনার খবর পাওয়া যায়নি। এরপর তারা সরাসরি মধ্যপ্রদেশের সেওনি জেলার পুলিশ কন্ট্রোল রুমে যোগাযোগ করে। দ্য কুইন্ট ও বুমকে সেওনি জেলার পুলিশ সুপারের দপ্তর থেকে স্পষ্ট জানানো হয়—তাদের জানামতে এমন কোনো ঘটনা ঘটেনি।

পেঞ্চ টাইগার রিজার্ভের উপপরিচালক রাজনীশ সিংহের সঙ্গে যোগাযোগ করে বিষয়টি যাচাই করা হয়। তিনি বলেন, ভিডিওটির সঙ্গে পেঞ্চ এলাকার কোনো সম্পর্ক নেই। তিনি আরও ব্যাখ্যা দেন, বনের বাঘের সঙ্গে এমন ঘনিষ্ঠভাবে মানুষের যোগাযোগ সম্ভব নয়, যদি না বাঘটিকে বন্দী করে দীর্ঘদিন ধরে পোষ মানানো হয়। তাঁর ভাষায়, ‘বনের বাঘ কখনো এমন আচরণ করে না, এটা বাস্তবে সম্ভব নয়।’

ভিডিওর সন্দেহজনক দিক বা ভিজ্যুয়াল অসংগতি

বুম ভিডিওটির একটি উচ্চমানের সংস্করণ সংগ্রহ করে তাতে কিছু অস্বাভাবিক দিক লক্ষ করে। দেখা যায়, ভিডিওটির পটভূমির দৃশ্যে কিছু অস্পষ্ট বস্তু নড়াচড়া করছে, যা বাস্তব ভিডিওর মতো স্বাভাবিক নয়।

বাঘের মাথায় হাত রাখা ব্যক্তির আঙুলগুলো বিকৃতভাবে বাঁকানো, যেন সফটওয়্যারে তৈরি কৃত্রিম ছায়া। এমনকি হাতে থাকা বোতলের মুখ কখনো দেখা যায়, আবার মিলিয়ে যায়—এই ভিজ্যুয়াল অসংগতিগুলো ইঙ্গিত দেয়, এটি ধারণকৃত কোনো ফুটেজ নয়। সব মিলিয়ে ভিডিওটির একাধিক ফ্রেমে গ্রাফিক বিকৃতি স্পষ্ট।

কৃত্রিম বুদ্ধিমত্তানির্ভর বিশ্লেষণ

এরপর ভিডিওটি পরীক্ষা করা হয় ডিপফেক-ও-মিটার নামের একটি উন্নত টুলে। এটি তৈরি করেছে ইউনিভার্সিটি অব বাফেলোর মিডিয়া ফরেনসিকস ল্যাব। এই টুল ভিডিওটির বিভিন্ন অংশ বিশ্লেষণ করে দেখায়, এতে ‘উল্লেখযোগ্য মাত্রায় কৃত্রিম বুদ্ধিমত্তাভিত্তিক নির্মাণের চিহ্ন’ রয়েছে।

এরপর বুম তাদের অংশীদার ডিপফেক অ্যানালাইসিস ইউনিটের সাহায্য নেয়। তারা ভিডিওটি পরীক্ষা করে ‘Is It AI’ এবং ‘AI Or Not’—নামক দুটি আলাদা টুলে। উভয় টুলের বিশ্লেষণে দেখা যায়, ভিডিওটি এআই দিয়ে নির্মিত হওয়ার সম্ভাবনা প্রায় ৬৯ শতাংশ।

এই ফলাফল অনুযায়ী বিশেষজ্ঞরা বলেন, ভিডিওর মানুষের সঙ্গে প্রাণীর মিথস্ক্রিয়া এবং আলো-ছায়ার ত্রুটি স্পষ্ট করে দিচ্ছে এটি আসল নয়, বরং জেনারেটিভ এআই প্রযুক্তি ব্যবহার করে বানানো একটি দৃশ্য।

ভিডিওটি ছড়িয়ে পড়ার পর বহু ব্যবহারকারী এটিকে সত্যি বলে বিশ্বাস করেছেন। কিছু পোস্টে দাবি করা হয়েছে, ভিডিওর ওই ব্যক্তির নাম রাজু পাতিল। ৫২ বছর বয়সী ওই ব্যক্তি একজন দিনমজুর। তিনি নেশাগ্রস্ত অবস্থায় রাস্তায় বাঘটিকে আদর করছিলেন এবং আশ্চর্যজনকভাবে অক্ষত অবস্থায় রয়ে গেছেন।

একাধিক কৃত্রিম বুদ্ধিমত্তা শনাক্তকরণ টুলের ফলাফল এবং প্রশাসনিক যাচাই মিলিয়ে নিশ্চিতভাবে বলা যায়—ভিডিওটি বাস্তব নয়, বরং এআই প্রযুক্তি দিয়ে তৈরি একটি কৃত্রিম দৃশ্য। পেঞ্চ টাইগার রিজার্ভের উপপরিচালক রাজনীশ সিংহও সংবাদমাধ্যমকে বলেছেন, ‘এই ভিডিওর কোনো অংশই পেঞ্চের নয়। এটি সম্পূর্ণ ভুয়া।’

আমিল খানের ভ্যালেন্ট প্রজেক্ট দেখতে পেয়েছে, এই প্রক্রিয়ার আরও উন্নত পদ্ধতি ব্যবহৃত হয়েছে রাশিয়া থেকে ইউরোপে অপতথ্য ছড়ানোর ক্ষেত্রে। বিশেষ করে, ব্রিটেনে কট্টর ডানপন্থী কনটেন্ট ছড়ানোর আগে, স্প্রেডার অ্যাকাউন্টগুলো ব্রিটিশ রাজপরিবার সংক্রান্ত বিভিন্ন মুখরোচক গল্প প্রচার/প্রকাশ করে ফলোয়ারদের আকৃষ্ট করেছ

০৮ মে ২০২৪

সম্প্রতি আজকের পত্রিকার নাম ও ফটোকার্ড ব্যবহার করে ‘হরেকৃষ্ণ হরিবোল, দাঁড়িপাল্লা টেনে তোলঃ পরওয়ার’ শিরোনামে একটি ভুয়া ফটোকার্ড সামাজিক যোগাযোগমাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে।

০৩ নভেম্বর ২০২৫

বাংলাদেশের প্রধান উপদেষ্টা অধ্যাপক মুহাম্মদ ইউনূস পাকিস্তানের যৌথবাহিনীর চেয়ারম্যানকে ভারতের উত্তর-পূর্বাঞ্চল যুক্ত বাংলাদেশের মানচিত্রসংবলিত পতাকা উপহার দিয়েছেন বলে ভারতের সংবাদমাধ্যম ইন্ডিয়া টুডের দাবি সম্পূর্ণ অসত্য ও কল্পনাপ্রসূত বলে জানিয়েছে সিএ (প্রধান উপদেষ্টা) ফ্যাক্ট চেক।

২৮ অক্টোবর ২০২৫

একটি মেরিন পার্কে এক নারী প্রশিক্ষককে চুবিয়ে হত্যা করেছে অরকা বা কিলার তিমি। সামাজিক যোগাযোগ মাধ্যমে এমন একটি ভিডিও ভাইরাল হয়েছে।

১৩ আগস্ট ২০২৫ফ্যাক্টচেক ডেস্ক

বাংলাদেশের প্রধান উপদেষ্টা অধ্যাপক মুহাম্মদ ইউনূস পাকিস্তানের যৌথবাহিনীর চেয়ারম্যানকে ভারতের উত্তর-পূর্বাঞ্চল যুক্ত বাংলাদেশের মানচিত্রসংবলিত পতাকা উপহার দিয়েছেন বলে ভারতের সংবাদমাধ্যম ইন্ডিয়া টুডের দাবি সম্পূর্ণ অসত্য ও কল্পনাপ্রসূত বলে জানিয়েছে সিএ (প্রধান উপদেষ্টা) ফ্যাক্ট চেক।

ভারতের সংবাদমাধ্যমটি গতকাল এক প্রতিবেদনে দাবি করে, পাকিস্তানের যৌথবাহিনীর চেয়ারম্যান জেনারেল সাহির শামশাদ মির্জাকে এমন একটি পতাকা উপহার দিয়েছেন অধ্যাপক ইউনূস, যেখানে ভারতের উত্তর-পূর্বাঞ্চল বাংলাদেশের মানচিত্রের সঙ্গে যুক্ত করা হয়েছে।

সিএ ফ্যাক্ট চেক জানায়, প্রকৃতপক্ষে অধ্যাপক ইউনূস উপহার দিয়েছেন ‘দ্য আর্ট অব ট্রায়াম্ফ’ নামে একটি চিত্রসংকলন—যেখানে জুলাই গণঅভ্যুত্থানের সময় ঢাকাসহ দেশের বিভিন্ন স্থানে শিক্ষার্থীদের আঁকা রঙিন গ্রাফিতি ও দেয়ালচিত্র সংকলিত হয়েছে।

‘দ্য আর্ট অব ট্রায়াম্ফ’ জুলাই স্মৃতি ফাউন্ডেশন প্রকাশিত একটি সচিত্র দলিল, যেখানে ছাত্র-জনতার আত্মত্যাগে অর্জিত বিপ্লবের ইতিহাস ফুটে উঠেছে।

গ্রাফিতি সংকলনের প্রচ্ছদে জুলাই গণঅভ্যুত্থানের শহীদ আবু সাইদের পিছনে রক্তরাঙ্গা বাংলাদেশের মানচিত্র প্রদর্শিত হয়েছে।

প্রচ্ছদে দৃশ্যমান মানচিত্রটি গ্রাফিতি হিসেবে অঙ্কিত হওয়ায় বাংলাদেশের মূল মানচিত্রের পরিমাপের কিছুটা হেরফের হয়েছে বলে কারো কাছে মনে হতে পারে। কিন্তু ভারতের উত্তর পূর্বাঞ্চলের কোনো অংশ গ্রাফিতি মানচিত্রটিতে অন্তর্ভুক্ত হয়েছে বলে দাবি করাটা সম্পূর্ণ অসত্য এবং কল্পনাপ্রসূত। বাংলাদেশের মানচিত্রের সাথে উল্লেখিত গ্রাফিতিতে দৃশ্যমান মানচিত্রের তুলনামূলক বিশ্লেষণে দেখা যাচ্ছে, অঙ্কিত মানচিত্রটিতে বাংলাদেশের প্রকৃত মানচিত্র প্রায় হুবহুভাবেই প্রতিফলিত হয়েছে।

প্রধান উপদেষ্টা এর আগেও একই গ্রাফিতি সংকলন ‘দ্য আর্ট অব ট্রায়াম্ফ’ জাতিসংঘের মহাসচিব, সাবেক মার্কিন প্রেসিডেন্ট জো বাইডেন এবং কানাডার প্রধানমন্ত্রী জাস্টিন ট্রুডোসহ বিশ্ব নেতাদের উপহার দিয়েছেন।

বাংলাদেশের প্রধান উপদেষ্টা অধ্যাপক মুহাম্মদ ইউনূস পাকিস্তানের যৌথবাহিনীর চেয়ারম্যানকে ভারতের উত্তর-পূর্বাঞ্চল যুক্ত বাংলাদেশের মানচিত্রসংবলিত পতাকা উপহার দিয়েছেন বলে ভারতের সংবাদমাধ্যম ইন্ডিয়া টুডের দাবি সম্পূর্ণ অসত্য ও কল্পনাপ্রসূত বলে জানিয়েছে সিএ (প্রধান উপদেষ্টা) ফ্যাক্ট চেক।

ভারতের সংবাদমাধ্যমটি গতকাল এক প্রতিবেদনে দাবি করে, পাকিস্তানের যৌথবাহিনীর চেয়ারম্যান জেনারেল সাহির শামশাদ মির্জাকে এমন একটি পতাকা উপহার দিয়েছেন অধ্যাপক ইউনূস, যেখানে ভারতের উত্তর-পূর্বাঞ্চল বাংলাদেশের মানচিত্রের সঙ্গে যুক্ত করা হয়েছে।

সিএ ফ্যাক্ট চেক জানায়, প্রকৃতপক্ষে অধ্যাপক ইউনূস উপহার দিয়েছেন ‘দ্য আর্ট অব ট্রায়াম্ফ’ নামে একটি চিত্রসংকলন—যেখানে জুলাই গণঅভ্যুত্থানের সময় ঢাকাসহ দেশের বিভিন্ন স্থানে শিক্ষার্থীদের আঁকা রঙিন গ্রাফিতি ও দেয়ালচিত্র সংকলিত হয়েছে।

‘দ্য আর্ট অব ট্রায়াম্ফ’ জুলাই স্মৃতি ফাউন্ডেশন প্রকাশিত একটি সচিত্র দলিল, যেখানে ছাত্র-জনতার আত্মত্যাগে অর্জিত বিপ্লবের ইতিহাস ফুটে উঠেছে।

গ্রাফিতি সংকলনের প্রচ্ছদে জুলাই গণঅভ্যুত্থানের শহীদ আবু সাইদের পিছনে রক্তরাঙ্গা বাংলাদেশের মানচিত্র প্রদর্শিত হয়েছে।

প্রচ্ছদে দৃশ্যমান মানচিত্রটি গ্রাফিতি হিসেবে অঙ্কিত হওয়ায় বাংলাদেশের মূল মানচিত্রের পরিমাপের কিছুটা হেরফের হয়েছে বলে কারো কাছে মনে হতে পারে। কিন্তু ভারতের উত্তর পূর্বাঞ্চলের কোনো অংশ গ্রাফিতি মানচিত্রটিতে অন্তর্ভুক্ত হয়েছে বলে দাবি করাটা সম্পূর্ণ অসত্য এবং কল্পনাপ্রসূত। বাংলাদেশের মানচিত্রের সাথে উল্লেখিত গ্রাফিতিতে দৃশ্যমান মানচিত্রের তুলনামূলক বিশ্লেষণে দেখা যাচ্ছে, অঙ্কিত মানচিত্রটিতে বাংলাদেশের প্রকৃত মানচিত্র প্রায় হুবহুভাবেই প্রতিফলিত হয়েছে।

প্রধান উপদেষ্টা এর আগেও একই গ্রাফিতি সংকলন ‘দ্য আর্ট অব ট্রায়াম্ফ’ জাতিসংঘের মহাসচিব, সাবেক মার্কিন প্রেসিডেন্ট জো বাইডেন এবং কানাডার প্রধানমন্ত্রী জাস্টিন ট্রুডোসহ বিশ্ব নেতাদের উপহার দিয়েছেন।

আমিল খানের ভ্যালেন্ট প্রজেক্ট দেখতে পেয়েছে, এই প্রক্রিয়ার আরও উন্নত পদ্ধতি ব্যবহৃত হয়েছে রাশিয়া থেকে ইউরোপে অপতথ্য ছড়ানোর ক্ষেত্রে। বিশেষ করে, ব্রিটেনে কট্টর ডানপন্থী কনটেন্ট ছড়ানোর আগে, স্প্রেডার অ্যাকাউন্টগুলো ব্রিটিশ রাজপরিবার সংক্রান্ত বিভিন্ন মুখরোচক গল্প প্রচার/প্রকাশ করে ফলোয়ারদের আকৃষ্ট করেছ

০৮ মে ২০২৪

সম্প্রতি আজকের পত্রিকার নাম ও ফটোকার্ড ব্যবহার করে ‘হরেকৃষ্ণ হরিবোল, দাঁড়িপাল্লা টেনে তোলঃ পরওয়ার’ শিরোনামে একটি ভুয়া ফটোকার্ড সামাজিক যোগাযোগমাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে।

০৩ নভেম্বর ২০২৫

সামাজিক যোগাযোগমাধ্যমে সম্প্রতি ভাইরাল একটি ভিডিওতে দেখা যাচ্ছে, রাতের রাস্তার মাঝখানে এক মধ্যবয়সী ব্যক্তি এক হাতে একটি স্বচ্ছ বোতল, অপর হাতে বাঘের মাথায় হাত বুলিয়ে দিচ্ছেন। এমনকি বাঘটির মুখে বোতল গুঁজে দিতেও দেখা যায় তাঁকে।

০২ নভেম্বর ২০২৫

একটি মেরিন পার্কে এক নারী প্রশিক্ষককে চুবিয়ে হত্যা করেছে অরকা বা কিলার তিমি। সামাজিক যোগাযোগ মাধ্যমে এমন একটি ভিডিও ভাইরাল হয়েছে।

১৩ আগস্ট ২০২৫ফ্যাক্টচেক ডেস্ক

একটি মেরিন পার্কে এক নারী প্রশিক্ষককে চুবিয়ে হত্যা করেছে অরকা বা কিলার তিমি। সামাজিক যোগাযোগ মাধ্যমে এমন একটি ভিডিও ভাইরাল হয়েছে। মর্মান্তিক ভিডিওটি সামাজিক যোগাযোগ মাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে। ভিডিওতে দাবি করা হয়, প্যাসিফিক ব্লু মেরিন পার্কে ‘জেসিকা র্যাডক্লিফ’ নামে একজন প্রশিক্ষককে একটি অরকা আক্রমণ করে হত্যা করেছে।

ভিডিওটি টিকটক, ফেসবুক এবং এক্সে ভাইরাল হয়েছে। তবে, একাধিক ফ্যাক্ট-চেকিং সংস্থা নিশ্চিত করেছে যে, এই ভিডিওটি সম্পূর্ণ বানোয়াট এবং এর কোনো বাস্তব ভিত্তি নেই।

ভিডিওতে যা দেখানো হয়েছে

ভাইরাল হওয়া ক্লিপটিতে দেখা যায়, একজন তরুণী একটি অরকার পিঠে দাঁড়িয়ে নাচছেন। দর্শকেরা তখন উল্লাস করছিল। কিন্তু কিছুক্ষণ পর হঠাৎ অরকাটি ওই তরুণীকে আক্রমণ করে পানির নিচে টেনে নিয়ে যায়। ভিডিওটি শেয়ার করা অনেক ব্যবহারকারী দাবি করেছেন, পানির নিচে নিয়ে যাওয়ার কয়েক মিনিটের মধ্যেই ওই তরুণীর মৃত্যু হয়।

ঘটনা বা প্রশিক্ষকের কোনো প্রমাণ নেই

ভিডিওটি ব্যাপকভাবে শেয়ার হওয়া সত্ত্বেও, জেসিকা র্যাডক্লিফ নামে একজন প্রশিক্ষক অরকার আক্রমণে মারা গেছেন—এই দাবির পক্ষে কোনো বিশ্বাসযোগ্য প্রমাণ পাওয়া যায়নি। কর্তৃপক্ষ, মেরিন পার্ক এবং প্রতিষ্ঠিত সংবাদমাধ্যমগুলো জেসিকা র্যাডক্লিফের অস্তিত্ব বা এমন কোনো ঘটনার রেকর্ড খুঁজে পায়নি। দ্য স্টার পত্রিকার মতে, ভিডিওটি কাল্পনিক; এমনকি ভিডিওতে থাকা কণ্ঠস্বরগুলোও কৃত্রিম বুদ্ধিমত্তার মাধ্যমে তৈরি বলে মনে করা হচ্ছে।

অন্যান্য প্রতিবেদন থেকে জানা গেছে, এমন দুর্ঘটনার ক্ষেত্রে সাধারণত যে ধরনের আনুষ্ঠানিক বিবৃতি দেওয়া হয়, এই ঘটনায় তার কোনোটিই পাওয়া যায়নি। ফরেনসিক বিশ্লেষণ অনুসারে, ভিডিওর মধ্যে পানির অস্বাভাবিক গতিবিধি এবং অদ্ভুত বিরতিও নিশ্চিত করে যে এটি কৃত্রিম বুদ্ধিমত্তার মাধ্যমে তৈরি করা হয়েছে। এমনকি ভিডিওতে যে পার্কের নাম বলা হয়েছে, সেটিও ভুয়া।

সম্পূর্ণভাবে এআই-নির্মিত

ফোর্বস ম্যাগাজিন ক্লিপটিকে ‘একটি প্রতারণা’ বলে চিহ্নিত করেছে। তারা উল্লেখ করেছে, এমন একটি মর্মান্তিক ঘটনা যদি সত্যিই ঘটতো, তাহলে তা আন্তর্জাতিক সংবাদমাধ্যমে শিরোনাম হতো। ভিডিওর দৃশ্য এবং শব্দ সম্ভবত চাঞ্চল্যকর প্রভাব তৈরির জন্য কৃত্রিম বুদ্ধিমত্তা টুল দিয়ে সাজানো হয়েছে। দ্য ইকোনমিক টাইমস উল্লেখ করেছে, এই গল্পের চরিত্র এবং নাম কোনো যাচাইযোগ্য রেকর্ডের সঙ্গে মেলে না। ফলে বলা যেতে পারে যে, পুরো গল্পটি বানোয়াট।

সত্যিকারের দুর্ঘটনার সঙ্গে মিল

এই ধরনের প্রতারণামূলক ভিডিওগুলোতে কিছুটা সত্যের ওপর ভিত্তি করে বিশ্বাসযোগ্যতা অর্জনের চেষ্টা করা হয়। ভিডিওটি ২০১০ সালে সি ওয়ার্ল্ডে ডন ব্রাঞ্চেউ এবং ২০০৯ সালে অ্যালেক্সিস মার্টিনেজ-এর বাস্তব জীবনের মৃত্যুর ঘটনা স্মরণ করিয়ে দেয়। উভয় প্রশিক্ষকই অরকার আক্রমণে মারা যান। কিন্তু এই ঘটনাগুলো জেসিকা র্যাডক্লিফের গল্পের মতো নয়, কারণ সেগুলো নথিভুক্ত এবং কর্তৃপক্ষের তরফে নিশ্চিত করা হয়েছে।

কেন এই ধরনের প্রতারণা ভাইরাল হয়

বিশেষজ্ঞরা বলেন, একটি ভিডিওর আবেগপূর্ণ তীব্রতা এবং বাস্তবসম্মত উৎপাদন কৌশল এটি ভাইরাল হতে সাহায্য করে। এই ধরনের ক্লিপগুলো বুদ্ধিমান সামুদ্রিক স্তন্যপায়ী প্রাণীদের বন্দী করে রাখার নৈতিকতা নিয়ে মানুষের গভীর উদ্বেগগুলোকে কাজে লাগায়। একই সঙ্গে, এগুলো চাঞ্চল্যকর বিষয়বস্তু ব্যবহার করে দ্রুত ছড়িয়ে পড়ে। পরবর্তীতে ফ্যাক্টচেকিং হলেও ততক্ষণে অনেক দেরি হয়ে যায়।

কথিত জেসিকা র্যাডক্লিফকে নিয়ে অরকার আক্রমণের ভিডিওটি একটি সম্পূর্ণ বানোয়াট। এমন কোনো ঘটনাই ঘটেনি। এই নামে কোনো প্রশিক্ষকের অস্তিত্বেরও কোনো প্রমাণ নেই।

একটি মেরিন পার্কে এক নারী প্রশিক্ষককে চুবিয়ে হত্যা করেছে অরকা বা কিলার তিমি। সামাজিক যোগাযোগ মাধ্যমে এমন একটি ভিডিও ভাইরাল হয়েছে। মর্মান্তিক ভিডিওটি সামাজিক যোগাযোগ মাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে। ভিডিওতে দাবি করা হয়, প্যাসিফিক ব্লু মেরিন পার্কে ‘জেসিকা র্যাডক্লিফ’ নামে একজন প্রশিক্ষককে একটি অরকা আক্রমণ করে হত্যা করেছে।

ভিডিওটি টিকটক, ফেসবুক এবং এক্সে ভাইরাল হয়েছে। তবে, একাধিক ফ্যাক্ট-চেকিং সংস্থা নিশ্চিত করেছে যে, এই ভিডিওটি সম্পূর্ণ বানোয়াট এবং এর কোনো বাস্তব ভিত্তি নেই।

ভিডিওতে যা দেখানো হয়েছে

ভাইরাল হওয়া ক্লিপটিতে দেখা যায়, একজন তরুণী একটি অরকার পিঠে দাঁড়িয়ে নাচছেন। দর্শকেরা তখন উল্লাস করছিল। কিন্তু কিছুক্ষণ পর হঠাৎ অরকাটি ওই তরুণীকে আক্রমণ করে পানির নিচে টেনে নিয়ে যায়। ভিডিওটি শেয়ার করা অনেক ব্যবহারকারী দাবি করেছেন, পানির নিচে নিয়ে যাওয়ার কয়েক মিনিটের মধ্যেই ওই তরুণীর মৃত্যু হয়।

ঘটনা বা প্রশিক্ষকের কোনো প্রমাণ নেই

ভিডিওটি ব্যাপকভাবে শেয়ার হওয়া সত্ত্বেও, জেসিকা র্যাডক্লিফ নামে একজন প্রশিক্ষক অরকার আক্রমণে মারা গেছেন—এই দাবির পক্ষে কোনো বিশ্বাসযোগ্য প্রমাণ পাওয়া যায়নি। কর্তৃপক্ষ, মেরিন পার্ক এবং প্রতিষ্ঠিত সংবাদমাধ্যমগুলো জেসিকা র্যাডক্লিফের অস্তিত্ব বা এমন কোনো ঘটনার রেকর্ড খুঁজে পায়নি। দ্য স্টার পত্রিকার মতে, ভিডিওটি কাল্পনিক; এমনকি ভিডিওতে থাকা কণ্ঠস্বরগুলোও কৃত্রিম বুদ্ধিমত্তার মাধ্যমে তৈরি বলে মনে করা হচ্ছে।

অন্যান্য প্রতিবেদন থেকে জানা গেছে, এমন দুর্ঘটনার ক্ষেত্রে সাধারণত যে ধরনের আনুষ্ঠানিক বিবৃতি দেওয়া হয়, এই ঘটনায় তার কোনোটিই পাওয়া যায়নি। ফরেনসিক বিশ্লেষণ অনুসারে, ভিডিওর মধ্যে পানির অস্বাভাবিক গতিবিধি এবং অদ্ভুত বিরতিও নিশ্চিত করে যে এটি কৃত্রিম বুদ্ধিমত্তার মাধ্যমে তৈরি করা হয়েছে। এমনকি ভিডিওতে যে পার্কের নাম বলা হয়েছে, সেটিও ভুয়া।

সম্পূর্ণভাবে এআই-নির্মিত

ফোর্বস ম্যাগাজিন ক্লিপটিকে ‘একটি প্রতারণা’ বলে চিহ্নিত করেছে। তারা উল্লেখ করেছে, এমন একটি মর্মান্তিক ঘটনা যদি সত্যিই ঘটতো, তাহলে তা আন্তর্জাতিক সংবাদমাধ্যমে শিরোনাম হতো। ভিডিওর দৃশ্য এবং শব্দ সম্ভবত চাঞ্চল্যকর প্রভাব তৈরির জন্য কৃত্রিম বুদ্ধিমত্তা টুল দিয়ে সাজানো হয়েছে। দ্য ইকোনমিক টাইমস উল্লেখ করেছে, এই গল্পের চরিত্র এবং নাম কোনো যাচাইযোগ্য রেকর্ডের সঙ্গে মেলে না। ফলে বলা যেতে পারে যে, পুরো গল্পটি বানোয়াট।

সত্যিকারের দুর্ঘটনার সঙ্গে মিল

এই ধরনের প্রতারণামূলক ভিডিওগুলোতে কিছুটা সত্যের ওপর ভিত্তি করে বিশ্বাসযোগ্যতা অর্জনের চেষ্টা করা হয়। ভিডিওটি ২০১০ সালে সি ওয়ার্ল্ডে ডন ব্রাঞ্চেউ এবং ২০০৯ সালে অ্যালেক্সিস মার্টিনেজ-এর বাস্তব জীবনের মৃত্যুর ঘটনা স্মরণ করিয়ে দেয়। উভয় প্রশিক্ষকই অরকার আক্রমণে মারা যান। কিন্তু এই ঘটনাগুলো জেসিকা র্যাডক্লিফের গল্পের মতো নয়, কারণ সেগুলো নথিভুক্ত এবং কর্তৃপক্ষের তরফে নিশ্চিত করা হয়েছে।

কেন এই ধরনের প্রতারণা ভাইরাল হয়

বিশেষজ্ঞরা বলেন, একটি ভিডিওর আবেগপূর্ণ তীব্রতা এবং বাস্তবসম্মত উৎপাদন কৌশল এটি ভাইরাল হতে সাহায্য করে। এই ধরনের ক্লিপগুলো বুদ্ধিমান সামুদ্রিক স্তন্যপায়ী প্রাণীদের বন্দী করে রাখার নৈতিকতা নিয়ে মানুষের গভীর উদ্বেগগুলোকে কাজে লাগায়। একই সঙ্গে, এগুলো চাঞ্চল্যকর বিষয়বস্তু ব্যবহার করে দ্রুত ছড়িয়ে পড়ে। পরবর্তীতে ফ্যাক্টচেকিং হলেও ততক্ষণে অনেক দেরি হয়ে যায়।

কথিত জেসিকা র্যাডক্লিফকে নিয়ে অরকার আক্রমণের ভিডিওটি একটি সম্পূর্ণ বানোয়াট। এমন কোনো ঘটনাই ঘটেনি। এই নামে কোনো প্রশিক্ষকের অস্তিত্বেরও কোনো প্রমাণ নেই।

আমিল খানের ভ্যালেন্ট প্রজেক্ট দেখতে পেয়েছে, এই প্রক্রিয়ার আরও উন্নত পদ্ধতি ব্যবহৃত হয়েছে রাশিয়া থেকে ইউরোপে অপতথ্য ছড়ানোর ক্ষেত্রে। বিশেষ করে, ব্রিটেনে কট্টর ডানপন্থী কনটেন্ট ছড়ানোর আগে, স্প্রেডার অ্যাকাউন্টগুলো ব্রিটিশ রাজপরিবার সংক্রান্ত বিভিন্ন মুখরোচক গল্প প্রচার/প্রকাশ করে ফলোয়ারদের আকৃষ্ট করেছ

০৮ মে ২০২৪

সম্প্রতি আজকের পত্রিকার নাম ও ফটোকার্ড ব্যবহার করে ‘হরেকৃষ্ণ হরিবোল, দাঁড়িপাল্লা টেনে তোলঃ পরওয়ার’ শিরোনামে একটি ভুয়া ফটোকার্ড সামাজিক যোগাযোগমাধ্যমে ব্যাপকভাবে ছড়িয়ে পড়েছে।

০৩ নভেম্বর ২০২৫

সামাজিক যোগাযোগমাধ্যমে সম্প্রতি ভাইরাল একটি ভিডিওতে দেখা যাচ্ছে, রাতের রাস্তার মাঝখানে এক মধ্যবয়সী ব্যক্তি এক হাতে একটি স্বচ্ছ বোতল, অপর হাতে বাঘের মাথায় হাত বুলিয়ে দিচ্ছেন। এমনকি বাঘটির মুখে বোতল গুঁজে দিতেও দেখা যায় তাঁকে।

০২ নভেম্বর ২০২৫

বাংলাদেশের প্রধান উপদেষ্টা অধ্যাপক মুহাম্মদ ইউনূস পাকিস্তানের যৌথবাহিনীর চেয়ারম্যানকে ভারতের উত্তর-পূর্বাঞ্চল যুক্ত বাংলাদেশের মানচিত্রসংবলিত পতাকা উপহার দিয়েছেন বলে ভারতের সংবাদমাধ্যম ইন্ডিয়া টুডের দাবি সম্পূর্ণ অসত্য ও কল্পনাপ্রসূত বলে জানিয়েছে সিএ (প্রধান উপদেষ্টা) ফ্যাক্ট চেক।

২৮ অক্টোবর ২০২৫