প্রযুক্তি ডেস্ক

চ্যাটজিপিটিতে সম্প্রতি নতুন একটি ত্রুটি দেখা দেয়। এই ত্রুটির কারণে অন্য ব্যবহারকারীদের কথোপকথনের শিরোনাম দেখতে পেয়েছেন কিছু ব্যবহারকারী। সোশ্যাল মিডিয়া সাইট রেডিট এবং টুইটারে কিছু ব্যবহারকারী তাদের চ্যাটজিপিটিতে চ্যাটের ইতিহাসের কিছু স্ক্রিনশট শেয়ার করেন। যেখানে দেখা যায় চ্যাটের তথ্যগুলো তাদের নয়।

বিবিসির প্রতিবেদন অনুযায়ী, ওপেনএআই’র প্রধান নির্বাহী স্যাম অল্টম্যান বলেন, ‘আমরা বিব্রত বোধ করছি, তবে এই ত্রুটিটি সংশোধন করা হয়েছে।’ অনেক ব্যবহারকারী চ্যাটজিপিটির গোপনীয়তা নিয়ে উদ্বিগ্ন থাকেন। গত নভেম্বরে এটি চালু হওয়ার পর থেকে লাখ লাখ মানুষ বার্তা খসড়া করতে, গান লিখতে এবং এমনকি কোড করতে এই প্ল্যাটফর্ম ব্যবহার করেছেন।

চ্যাটজিপিটিতে প্রতিটি চ্যাটের হিস্ট্রি সংরক্ষণ করা হয় যা পরে আবার দেখা যায়। তবে গত ২০ মার্চ থেকে ব্যবহারকারীরা তাদের চ্যাট হিস্ট্রিতে যে চ্যাট গুলো দেখতে পাচ্ছিলেন সেগুলো তাদের নয়। রেডিটে একজন ব্যবহারকারী তাঁর চ্যাটের ইতিহাসের একটি ছবি শেয়ার করেছেন যার শিরোনাম— চীনের সমাজতন্ত্র উন্নয়ন। পুরো কথোপকথনটি মান্দারিন ভাষায় করা হয়েছে।

চ্যাটজিপিটি জানিয়েছে, ত্রুটিটি ঠিক করা হয়েছে। এ ছাড়া, ব্যবহারকারীরা শুধু অন্যের চ্যাটের টাইটেল দেখতে পেয়েছিলেন। চ্যাট পড়তে পারেননি।

সম্প্রতি, চ্যাটজিপিটি নিয়ে নিজের শঙ্কার কথা জানান স্যাম অল্টম্যান। বিজনেস ইনসাইডারের প্রতিবেদন অনুযায়ী, এবিসি নিউজকে দেওয়া এক সাক্ষাৎকারে অল্টম্যান বলেন, ‘এআই চ্যাটবটটি অনেক ধরনের চাকরি বিলুপ্ত করবে। এটি যে সব কাজ করতে পারে তার জন্য আর মানুষের প্রয়োজন হবে না। মানুষ প্রমাণ করেছে, তারা প্রযুক্তিগত পরিবর্তনের সঙ্গে মানিয়ে নিতে পারে। তবে কিছু পরিবর্তন ১০ বছরেরও কম সময়ে ঘটবে।’

তিনি আরও বলেন, ‘মানুষের সৃষ্টিশীলতা সীমাহীন। মানুষ কোনো না কোনোভাবে নতুন কাজ খুঁজে নেয়।’

চ্যাটজিপিটির অপব্যবহার নিয়েও শঙ্কা প্রকাশ করে অল্টম্যান বলেন, ‘এআই ল্যাঙ্গুয়েজ মডেলগুলো বৃহৎ পরিসরে ভুয়া তথ্য ছড়ানোর কাজে ব্যবহার করা হতে পারে।’ সাইবার হামলা বাড়ার আশঙ্কার কথাও জানান অল্টম্যান। কারণ, ধীরে ধীরে কোডিংয়েও পারদর্শী হয়ে উঠছে চ্যাটজিপিটি। চ্যাটজিপিটি কৃত্রিম বুদ্ধিমত্তাভিত্তিক টুল হলেও তা মানুষই নিয়ন্ত্রণ করে। তাই কোন ধরনের মানুষ এটা নিয়ন্ত্রণ করছে সেটাও ভাবার বিষয়।

অল্টম্যান গত মাসে একাধিক টুইট বার্তার মাধ্যমে সতর্কবার্তা জানান। এক টুইটে তিনি লেখেন, পৃথিবী কৃত্রিম বুদ্ধিমত্তার ভয়ংকর প্রভাব থেকে বেশি দূরে নয়। আরেক টুইটে এআইকে নিয়ন্ত্রণের কথাও বলেন অল্টম্যান।

গত সপ্তাহে ওপেনএআই জিপিটি-৪ উন্মোচন করে। অল্টম্যান এই সংস্করণকে আগের সংস্করণের তুলনায় ‘কম পক্ষপাতদুষ্ট’ ও ‘আরও সৃজনশীল’ হিসেবে আখ্যা দিয়েছেন। জিপিটি-৪ ব্যবহার করতে হলে চ্যাটজিপিটির প্লাস সাবস্ক্রিপশন সেবা নিতে হবে। নতুন এই সংস্করণ আগের সংস্করণের তুলনায় আরও নির্ভুল হওয়ার পাশাপাশি ব্যবহারকারীদের সঙ্গে এটি আগের চেয়ে বেশি সময় ধরে সংলাপ করতে সক্ষম।

চ্যাটজিপিটিতে সম্প্রতি নতুন একটি ত্রুটি দেখা দেয়। এই ত্রুটির কারণে অন্য ব্যবহারকারীদের কথোপকথনের শিরোনাম দেখতে পেয়েছেন কিছু ব্যবহারকারী। সোশ্যাল মিডিয়া সাইট রেডিট এবং টুইটারে কিছু ব্যবহারকারী তাদের চ্যাটজিপিটিতে চ্যাটের ইতিহাসের কিছু স্ক্রিনশট শেয়ার করেন। যেখানে দেখা যায় চ্যাটের তথ্যগুলো তাদের নয়।

বিবিসির প্রতিবেদন অনুযায়ী, ওপেনএআই’র প্রধান নির্বাহী স্যাম অল্টম্যান বলেন, ‘আমরা বিব্রত বোধ করছি, তবে এই ত্রুটিটি সংশোধন করা হয়েছে।’ অনেক ব্যবহারকারী চ্যাটজিপিটির গোপনীয়তা নিয়ে উদ্বিগ্ন থাকেন। গত নভেম্বরে এটি চালু হওয়ার পর থেকে লাখ লাখ মানুষ বার্তা খসড়া করতে, গান লিখতে এবং এমনকি কোড করতে এই প্ল্যাটফর্ম ব্যবহার করেছেন।

চ্যাটজিপিটিতে প্রতিটি চ্যাটের হিস্ট্রি সংরক্ষণ করা হয় যা পরে আবার দেখা যায়। তবে গত ২০ মার্চ থেকে ব্যবহারকারীরা তাদের চ্যাট হিস্ট্রিতে যে চ্যাট গুলো দেখতে পাচ্ছিলেন সেগুলো তাদের নয়। রেডিটে একজন ব্যবহারকারী তাঁর চ্যাটের ইতিহাসের একটি ছবি শেয়ার করেছেন যার শিরোনাম— চীনের সমাজতন্ত্র উন্নয়ন। পুরো কথোপকথনটি মান্দারিন ভাষায় করা হয়েছে।

চ্যাটজিপিটি জানিয়েছে, ত্রুটিটি ঠিক করা হয়েছে। এ ছাড়া, ব্যবহারকারীরা শুধু অন্যের চ্যাটের টাইটেল দেখতে পেয়েছিলেন। চ্যাট পড়তে পারেননি।

সম্প্রতি, চ্যাটজিপিটি নিয়ে নিজের শঙ্কার কথা জানান স্যাম অল্টম্যান। বিজনেস ইনসাইডারের প্রতিবেদন অনুযায়ী, এবিসি নিউজকে দেওয়া এক সাক্ষাৎকারে অল্টম্যান বলেন, ‘এআই চ্যাটবটটি অনেক ধরনের চাকরি বিলুপ্ত করবে। এটি যে সব কাজ করতে পারে তার জন্য আর মানুষের প্রয়োজন হবে না। মানুষ প্রমাণ করেছে, তারা প্রযুক্তিগত পরিবর্তনের সঙ্গে মানিয়ে নিতে পারে। তবে কিছু পরিবর্তন ১০ বছরেরও কম সময়ে ঘটবে।’

তিনি আরও বলেন, ‘মানুষের সৃষ্টিশীলতা সীমাহীন। মানুষ কোনো না কোনোভাবে নতুন কাজ খুঁজে নেয়।’

চ্যাটজিপিটির অপব্যবহার নিয়েও শঙ্কা প্রকাশ করে অল্টম্যান বলেন, ‘এআই ল্যাঙ্গুয়েজ মডেলগুলো বৃহৎ পরিসরে ভুয়া তথ্য ছড়ানোর কাজে ব্যবহার করা হতে পারে।’ সাইবার হামলা বাড়ার আশঙ্কার কথাও জানান অল্টম্যান। কারণ, ধীরে ধীরে কোডিংয়েও পারদর্শী হয়ে উঠছে চ্যাটজিপিটি। চ্যাটজিপিটি কৃত্রিম বুদ্ধিমত্তাভিত্তিক টুল হলেও তা মানুষই নিয়ন্ত্রণ করে। তাই কোন ধরনের মানুষ এটা নিয়ন্ত্রণ করছে সেটাও ভাবার বিষয়।

অল্টম্যান গত মাসে একাধিক টুইট বার্তার মাধ্যমে সতর্কবার্তা জানান। এক টুইটে তিনি লেখেন, পৃথিবী কৃত্রিম বুদ্ধিমত্তার ভয়ংকর প্রভাব থেকে বেশি দূরে নয়। আরেক টুইটে এআইকে নিয়ন্ত্রণের কথাও বলেন অল্টম্যান।

গত সপ্তাহে ওপেনএআই জিপিটি-৪ উন্মোচন করে। অল্টম্যান এই সংস্করণকে আগের সংস্করণের তুলনায় ‘কম পক্ষপাতদুষ্ট’ ও ‘আরও সৃজনশীল’ হিসেবে আখ্যা দিয়েছেন। জিপিটি-৪ ব্যবহার করতে হলে চ্যাটজিপিটির প্লাস সাবস্ক্রিপশন সেবা নিতে হবে। নতুন এই সংস্করণ আগের সংস্করণের তুলনায় আরও নির্ভুল হওয়ার পাশাপাশি ব্যবহারকারীদের সঙ্গে এটি আগের চেয়ে বেশি সময় ধরে সংলাপ করতে সক্ষম।

কৃত্রিম বুদ্ধিমত্তা বা এআইভিত্তিক চ্যাটবট চ্যাটজিপিটি নিয়ে ভবিষ্যতবাণী করল ওপেনএআইয়ের সিইও স্যাম অল্টম্যান। সান ফ্রান্সিসকোতে এক সাংবাদিকদের সঙ্গে এক নৈশভোজে তিনি বলেন, চ্যাটজিপিটি এমন এক পর্যায়ে পৌঁছাবে যেখানে প্রতিদিন কোটি কোটি মানুষ এর সঙ্গে কথা বলবে। এমনকি, ভবিষ্যতে চ্যাটজিপিটি হয়তো মানুষের সমস্

১৪ ঘণ্টা আগে

চীনের বেইজিংয়ে শুরু হয়েছে তিন দিনব্যাপী বিশ্ব হিউম্যানয়েড বা মানবাকৃতির রোবট গেমস। গতকাল শুক্রবার (১৫ আগস্ট) শুরু হওয়া এই আয়োজনে ১৬টি দেশ থেকে ২৮০টি দল অংশ নিচ্ছে। কৃত্রিম বুদ্ধিমত্তা (এআই) ও রোবোটিক্সে নিজেদের অগ্রগতি তুলে ধরতেই এমন আয়োজন করেছে চীন।

১৬ ঘণ্টা আগে

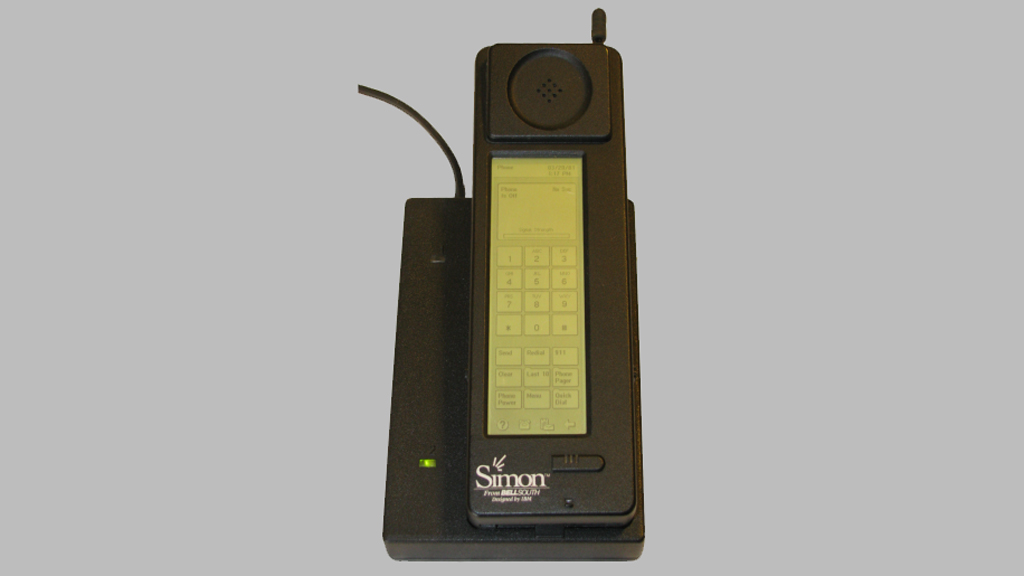

স্মার্টফোন এখন আমাদের দৈনন্দিন জীবনের অপরিহার্য অংশ। তবে শুরুর দিকের স্মার্টফোনগুলোতে এত ফিচার ছিল না এবং এত বিস্তৃত পরিসরেও ব্যবহার করা যেত না। সেই সময়ের স্মার্টফোনগুলো ছিল বড়, ভারী ও সীমিত ক্ষমতার।

১৭ ঘণ্টা আগে

বর্তমান প্রজন্মের সাজসজ্জায় এসেছে এক অভিনব পরিবর্তন। চোখের নিচে কালো দাগ, ফ্যাকাশে মুখ আর ঠোঁটে হালকা বেগুনি রং মিলিয়ে এক ধরনের ক্লান্ত ও অবসন্ন মেকআপ লুক এখন টিকটকে খুবই জনপ্রিয়। এত দিন চেহারার যেসব ক্লান্তির চিহ্ন লুকানোর চেষ্টা করা হতো, এখন সেটাই ‘টায়ার্ড গার্ল’ নামের নতুন ট্রেন্ড।

১৮ ঘণ্টা আগে